Задавайте вопросы - на всё найдём ответ

Сколько будет стоить?

Чё купить?

Ждать и копить, играя хз на чём? Или потратиться и не обновлять железо до лета 2007?

Всё, всё, всё про g80 и r600

(с) Аналитический клуб ..::GAMEINATOR::..

Полная версия этой страницы: DirectX 10, что это даст

затраты на ап компа

я вот щас о 4ем подумал : взять может х1800гто и оставить 200 про запас на дх10 карты,к тому времени еще баксов 200 скоплу будет 400 и тогда и купить можно будет топ карто4ку ... а может поступить наооборот и сей4ас взять х1900хт ,круто рубиться до нового года, а там дотянуть до лета ? просто не знаю с какой скорстью

дх 10 заменит дх9 в игросторроение и стоит ли тогда дожидаться земы без комфорта ? или зе стоит купит х1900хт и играть до земы с комфортом а потом дотянуть до лета ?

дх 10 заменит дх9 в игросторроение и стоит ли тогда дожидаться земы без комфорта ? или зе стоит купит х1900хт и играть до земы с комфортом а потом дотянуть до лета ?

Лично мне кажеться, что с этой карточкой-х1900хт можно будет почувствовать прелести игр и в 2008 году!

Цитата

Лично мне кажеться, что с этой карточкой-х1900хт можно будет почувствовать прелести игр и в 2008 году!

Да и в 2009, но только на дх9.

Правда помниться обещали dx9.0L (поддержка шейдеров 4.0)...

Illidian,

Возьми 7600GT - и не слабая и дешёвая!

А тратиться на 1900хт или хтх нет смысла, их быстро сменит предположим - "2000хтх" (на GPU r600).

Всё же думаю с приходом 10 директа придётся сменить не только видюху, ещё проц и мать 100%. Так что откладывайте деньги и ждите дх 10.

Мне почему то кажется что при испоьзовании DX 10 системные требования должны упасть,т.е. нагрузка на комп.(не спрашивайте почему,незнаю  )

)

-=LeKtoR=-, Предчувствие тебя не подводит.

Читаем статьи и делаем выводы.

]]>]]>

]]>]]>

Очевидно, что переход на DX10, позволит поднять производительность даже "устаревших" карт (с DX9).

Да и качество картинки сильно улучшится, в связи со снятием ограничения на количество объектов в кадре. Плюс - геометрические шейдеры, которые позволят сделать игровой мир полностью изменяемым.

Единственный минус - все это мы увидим только с переходом на Windows Vista...

Читаем статьи и делаем выводы.

]]>]]>

]]>]]>

Очевидно, что переход на DX10, позволит поднять производительность даже "устаревших" карт (с DX9).

Да и качество картинки сильно улучшится, в связи со снятием ограничения на количество объектов в кадре. Плюс - геометрические шейдеры, которые позволят сделать игровой мир полностью изменяемым.

Единственный минус - все это мы увидим только с переходом на Windows Vista...

В догонку...

Взято с ]]>]]>

Цитата

Физика силами GPU: несколько слов в защиту DirectX 9

Lexagon / 25.07.2006 09:32 / ссылка на материал / версия для печати

Некоторое время назад британские коллеги опубликовали сведения о лучшей приспособленности DirectX 10 для реализации физических расчётов силами графических чипов. Игры под DirectX 10 смогут обрабатывать больше объектов одновременно, эффекты станут зрелищнее, а пока разработчики игр не торопятся внедрять поддержку "физики" в играх с использованием DirectX 9. Поскольку DirectX 10 найдёт практическое применение только в 2007 году, то и ждать появления игр с продвинутой физикой, рассчитываемой силами GPU, в текущем году не приходилось.

Мы собирались опубликовать некоторые "реабилитирующие" сведения о поддержке физики силами совместимых с DirectX 9 видеокарт, но заметка на сайте HKE PC внесла небольшие коррективы в наши планы. Коллеги ссылались на интервью с директором подразделения ATI по изготовлению чипсетов, господином Стэном Оссиасом (Stan Ossias), в котором тот рассказывал о преимуществах DirectX 10 и унифицированной шейдерной архитектуры, которая найдёт применение в будущем флагманском видеочипе под кодовым именем R600. Собственно говоря, мы решили объединить две перекликающиеся темы в одной новости.

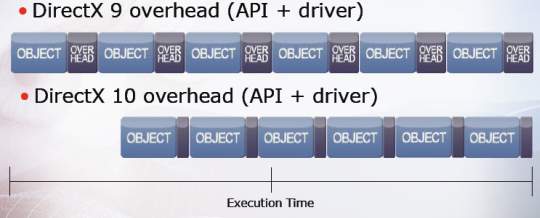

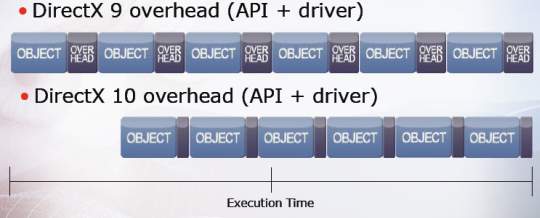

Начнём с описания преимуществ DirectX 10 в контексте использования игр с множеством объектов, наполняющих одну сцену. В приведённых коллегами фрагментах презентации ATI говорится об издержках времени на выполнение определённых действий с объектами. Приложение в своей работе обращается к драйверу видеокарты через программный интерфейс, которым в данном случае выступает DirectX той или иной версии. В DirectX 9 примерно 40% времени выполнения команд приходится на API и драйвер, и только 60% приходится на само приложение - в данном случае игру. Если так можно выразиться, для DirectX 9 непроизводительные затраты времени на выполнение действий с объектами выше, чем для DirectX 10.

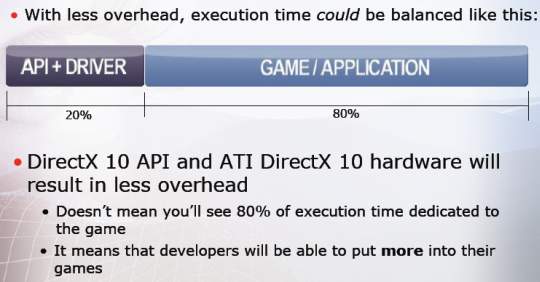

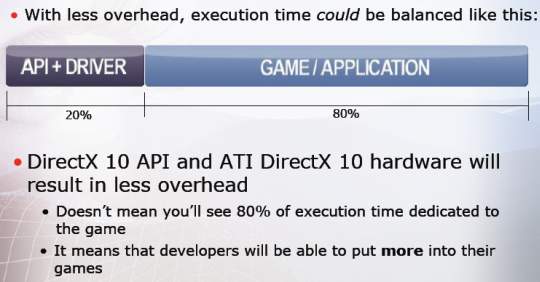

Переход на DirectX 10 и унифицированную шейдерную архитектуру (по отдельности их существование ATI себе представить не может) позволит сократить время выполнения операций с объектами. На долю приложения теперь может приходиться до 80% времени выполнения операции.

Казалось бы, это позволит повысить быстродействие игр. Отнюдь, разработчики просто истратят этот ресурс на обработку взаимодействия с большим числом объектов, а также на усложнение эффектов в играх. Речь идёт не только о физических эффектах, но и о повышении степени реалистичности визуальных эффектов. Одежда, волосы, листья, лица персонажей, тени и атмосферные эффекты - всё это станет ещё более зрелищным в играх на базе DirectX 10.

Кстати, преимущества DirectX 10 и быстродействие в играх будут раскрываться во многом силами драйверов, а не исключительно аппаратного обеспечения. По этой причине на разработку драйверов под DirectX 10 компания ATI бросила нешуточные материальные и человеческие ресурсы.

Теперь поговорим немного о реализации "физики" силами видеочипов, поддерживающих DirectX 9. Безусловно, DirectX 10 предлагает много преимуществ в реализации расчётов физических эффектов силами графического чипа. Многие разработчики решили отложить эксперименты в этой сфере до выхода DirectX 10. Однако, популяризовать "физику" только при содействии видеокарт класса R600 стоимостью $500-600 будет достаточно сложно. Решений среднего ценового диапазона с поддержкой DirectX 10 пока не видно в роадмапах ATI и nVidia, а ведь именно эти компании делают ставку на расчёт физики силами видеочипов.

По этим причинам разработчикам игр всё равно придётся в той или иной степени полагаться на DirectX 9 при создании игр с поддержкой Havok FX или аналогичных движков. Первое поколение таких игр будет использовать достаточно безопасные для самого игрового движка эффекты, которые будет проще реализовать. Будут ли эти эффекты достаточно зрелищными, нам только предстоит узнать.

Наконец, игровой индустрии для стимуляции перехода на активное использование "физики" нужен мощный толчок в виде одной-двух популярных игр с применением подобных технологий. Здесь действительно всё в руках разработчиков игр, и отдалённость широкой адаптации DirectX 10 не является в этом смысле главным сдерживающим фактором.

Как повлияет на дальнейшую деятельность в этой сфере покупка ATI компанией AMD, пока сказать сложно. Вряд ли канадская компания, теперь обретающая калифорнийскую прописку, откажется от своих планов, однако у новых владельцев ATI тоже могут быть свои предпочтения в этой сфере.

Lexagon / 25.07.2006 09:32 / ссылка на материал / версия для печати

Некоторое время назад британские коллеги опубликовали сведения о лучшей приспособленности DirectX 10 для реализации физических расчётов силами графических чипов. Игры под DirectX 10 смогут обрабатывать больше объектов одновременно, эффекты станут зрелищнее, а пока разработчики игр не торопятся внедрять поддержку "физики" в играх с использованием DirectX 9. Поскольку DirectX 10 найдёт практическое применение только в 2007 году, то и ждать появления игр с продвинутой физикой, рассчитываемой силами GPU, в текущем году не приходилось.

Мы собирались опубликовать некоторые "реабилитирующие" сведения о поддержке физики силами совместимых с DirectX 9 видеокарт, но заметка на сайте HKE PC внесла небольшие коррективы в наши планы. Коллеги ссылались на интервью с директором подразделения ATI по изготовлению чипсетов, господином Стэном Оссиасом (Stan Ossias), в котором тот рассказывал о преимуществах DirectX 10 и унифицированной шейдерной архитектуры, которая найдёт применение в будущем флагманском видеочипе под кодовым именем R600. Собственно говоря, мы решили объединить две перекликающиеся темы в одной новости.

Начнём с описания преимуществ DirectX 10 в контексте использования игр с множеством объектов, наполняющих одну сцену. В приведённых коллегами фрагментах презентации ATI говорится об издержках времени на выполнение определённых действий с объектами. Приложение в своей работе обращается к драйверу видеокарты через программный интерфейс, которым в данном случае выступает DirectX той или иной версии. В DirectX 9 примерно 40% времени выполнения команд приходится на API и драйвер, и только 60% приходится на само приложение - в данном случае игру. Если так можно выразиться, для DirectX 9 непроизводительные затраты времени на выполнение действий с объектами выше, чем для DirectX 10.

Переход на DirectX 10 и унифицированную шейдерную архитектуру (по отдельности их существование ATI себе представить не может) позволит сократить время выполнения операций с объектами. На долю приложения теперь может приходиться до 80% времени выполнения операции.

Казалось бы, это позволит повысить быстродействие игр. Отнюдь, разработчики просто истратят этот ресурс на обработку взаимодействия с большим числом объектов, а также на усложнение эффектов в играх. Речь идёт не только о физических эффектах, но и о повышении степени реалистичности визуальных эффектов. Одежда, волосы, листья, лица персонажей, тени и атмосферные эффекты - всё это станет ещё более зрелищным в играх на базе DirectX 10.

Кстати, преимущества DirectX 10 и быстродействие в играх будут раскрываться во многом силами драйверов, а не исключительно аппаратного обеспечения. По этой причине на разработку драйверов под DirectX 10 компания ATI бросила нешуточные материальные и человеческие ресурсы.

Теперь поговорим немного о реализации "физики" силами видеочипов, поддерживающих DirectX 9. Безусловно, DirectX 10 предлагает много преимуществ в реализации расчётов физических эффектов силами графического чипа. Многие разработчики решили отложить эксперименты в этой сфере до выхода DirectX 10. Однако, популяризовать "физику" только при содействии видеокарт класса R600 стоимостью $500-600 будет достаточно сложно. Решений среднего ценового диапазона с поддержкой DirectX 10 пока не видно в роадмапах ATI и nVidia, а ведь именно эти компании делают ставку на расчёт физики силами видеочипов.

По этим причинам разработчикам игр всё равно придётся в той или иной степени полагаться на DirectX 9 при создании игр с поддержкой Havok FX или аналогичных движков. Первое поколение таких игр будет использовать достаточно безопасные для самого игрового движка эффекты, которые будет проще реализовать. Будут ли эти эффекты достаточно зрелищными, нам только предстоит узнать.

Наконец, игровой индустрии для стимуляции перехода на активное использование "физики" нужен мощный толчок в виде одной-двух популярных игр с применением подобных технологий. Здесь действительно всё в руках разработчиков игр, и отдалённость широкой адаптации DirectX 10 не является в этом смысле главным сдерживающим фактором.

Как повлияет на дальнейшую деятельность в этой сфере покупка ATI компанией AMD, пока сказать сложно. Вряд ли канадская компания, теперь обретающая калифорнийскую прописку, откажется от своих планов, однако у новых владельцев ATI тоже могут быть свои предпочтения в этой сфере.

Взято с ]]>]]>

Приведу цитату с ссылки что дал Zeed

Все наверное знают требования для Висты?

Так что думаю что очередной апгрейд обойдется около 2000$ (Для Украины)

Цитата

DirectX 10 будет доступен только пользователям Windows Vista. Вы не найдете релиза DirectX 10 для Windows XP. DirectX 10 интегрирован с Vista и нам неизвестны планы о том, что Microsoft собирается официально поддержать новый API на ХР. В Windows Vista также интегрирован DirectX 9.0L для обеспечения совместимости с компонентами DirectX 9. Думайте об этом, как о двух разных DirectX в одной ОС. Мы будем иметь DirectX 9.0L для оборудования с поддержкой DirectX 9 и DirectX 10 для оборудования с поддержкой DirectX 10. Если вы хотите пользоваться DirectX 10, вам придется воспользоваться Windows Vista. И не исключено, что именно в связи с возможностями нового API будут связаны многочисленные переходы на новую ОС. Итак, вам будут нужны Windows Vista, оборудование с поддержкой DirectX 10 и, разумеется, игры, разработанные с учетом спецификаций DirectX 10.

Все наверное знают требования для Висты?

Так что думаю что очередной апгрейд обойдется около 2000$ (Для Украины)

Undertaker, Все не так страшно.

Достаточно будет просто докупить память до 2Gb (если, конечно, не откровенно слабая система).

Достаточно будет просто докупить память до 2Gb (если, конечно, не откровенно слабая система).

Zeed,

Я немного не о том. Я про то, что если брать топовый компьютер. И карту с поддержкой ДХ10.

Я немного не о том. Я про то, что если брать топовый компьютер. И карту с поддержкой ДХ10.

Цитата

думаю что очередной апгрейд обойдется около 2000$ (Для Украины)

Надеюсь что всё будет совсем не так.

Сейчас стандартом для большенства систем стало наличие 1гига рама.

Если делать "топовый ап" то учитывая отношения железа нового и железа старого, можно предположить, что материнка будет стоить порядка 180 - 250 долл., проц от 400 (если брать в расчёт 4 ядра) до 700., 1 гиг рама - 80$, и видюха... Это отдельный разговор.

Стоить заметить что производство новых видеокарт не сильно отличается от производства 7900GTX/1900XTX. Так что вполне верояткая цена 300 - 600 долл. для топовой видеокарты.

Was added in 7 minutes 30 seconds:

Значит мин. цена 960$. Макс. 1630

Hint,

Я брал вот како

Я брал вот како

Hint,

Я брал в пример вот какой конфиг:

7950 GX2 - 700$

Core 2 Duo - порядка 450 - 700$

4 гига оперы - 400$

Материнка - 300$

Итого: 1850$ - 2100$

Я брал в пример вот какой конфиг:

7950 GX2 - 700$

Core 2 Duo - порядка 450 - 700$

4 гига оперы - 400$

Материнка - 300$

Итого: 1850$ - 2100$

Цитата

7950 GX2

Ну дуал системы на g80 сразу не будет, так что цена от 300 до 600, не больше.

Цитата

Core 2 Duo - порядка 450 - 700$

Да не, 2 ядро будут не дорогими, там по 200 баксов, а вот Core 4 EE будет стоить 450 - 700$.

Цитата

4 гига оперы - 400$

Совсем не нжно, но даже если надумаешь купить то реаль цена одного гига 70 - 80$, получается 280 - 320$

Цитата

Материнка - 300$

Бессмысленная трата... Не более 200 долл.

1230 - 1820.

Но всё равно за 1000$ купленный комп будет тянуть всё игры 2006 - 2007 и возможно 2008 года.

Цитата

Но всё равно за 1000$ купленный комп будет тянуть всё игры 2006 - 2007 и возможно 2008 года.

Ну ты меня успокоил, а то я голову ломал сколько мне нужно на апгрейд, а вернее не апгрейд а полную смену компа. Хочу взять себе конфиг вроде того, что предложил Undertaker, но с 2 гигами оперативки

Hint,

radeon х1900хт стоит сейчас 600$

Блин, имел ввиду Core4.

Corsair одной платой на гиг 100$ на два 250-300$

+ это цены на территории Украины. В России может и дешевле.

Цитата

Ну дуал системы на g80 сразу не будет, так что цена от 300 до 600, не больше.

radeon х1900хт стоит сейчас 600$

Цитата

Core 2 Duo - порядка 450 - 700$

Да не, 2 ядро будут не дорогими, там по 200 баксов, а вот Core 4 EE будет стоить 450 - 700$.

Да не, 2 ядро будут не дорогими, там по 200 баксов, а вот Core 4 EE будет стоить 450 - 700$.

Блин, имел ввиду Core4.

Цитата

Совсем не нжно, но даже если надумаешь купить то реаль цена одного гига 70 - 80$,

Corsair одной платой на гиг 100$ на два 250-300$

+ это цены на территории Украины. В России может и дешевле.

Цитата

radeon х1900хт стоит сейчас 600$

]]>]]>

Цитата

Corsair на гиг 100$

А это уже не к чему

Цитата

+ это цены на территории Украины

Вам Грмания ближе... Уверен на Украине есть отличные и недорогие сервис центры.

Будет ли виста, со свойе 10 дерективой потдерживать видео с 9-ой? Либо нужно будет специально ставить 9-ю?

Цитата

Будет ли виста, со свойе 10 дерективой потдерживать видео с 9-ой? Либо нужно будет специально ставить 9-ю?

Чё?

***-=ARTI=-***,

Цитата

Будет ли виста, со свойе 10 дерективой потдерживать видео с 9-ой? Либо нужно будет специально ставить 9-ю?

Цитата

В Windows Vista также интегрирован DirectX 9.0L для обеспечения совместимости с компонентами DirectX 9. Думайте об этом, как о двух разных DirectX в одной ОС. Мы будем иметь DirectX 9.0L для оборудования с поддержкой DirectX 9 и DirectX 10 для оборудования с поддержкой DirectX 10.

Какие чипсеты материнских плат будут поддерживать core 2 duo?

Если вы собиретесь как раз купить себе новую материнскую плату и не знаете будет ли она поддерживать новые core 2, то вы вовремя зашли на эту тему... ну или позно .

.

Итак, core 2 duo будут поддерживать абсолютно все 965 чипсеты от интела и те версии 975 которые вышле после 17 марта 2006 года. Что бы выяснить, повезло вам или же нет, вам нужно поискать на текстолите мат. платы или на её упаковке номера типа АА***. И если вместо *** будут цифры "304" и выше то смело можете быть уверены что duo у вас будет работать абсолютно исправно.

Если вы собиретесь как раз купить себе новую материнскую плату и не знаете будет ли она поддерживать новые core 2, то вы вовремя зашли на эту тему... ну или позно

Итак, core 2 duo будут поддерживать абсолютно все 965 чипсеты от интела и те версии 975 которые вышле после 17 марта 2006 года. Что бы выяснить, повезло вам или же нет, вам нужно поискать на текстолите мат. платы или на её упаковке номера типа АА***. И если вместо *** будут цифры "304" и выше то смело можете быть уверены что duo у вас будет работать абсолютно исправно.

Саамое многое что оно сможет дать ЭТО БОЛЬШЕ тормозов!

Alex(xt),

Возможно, пока дх10 не будет полность зализан под Висту):

Цитата

Саамое многое что оно сможет дать ЭТО БОЛЬШЕ тормозов!

Возможно, пока дх10 не будет полность зализан под Висту):

Alex(xt),

Посмотри на The Elder Scrolls 4: Oblivion. Что ты видишь?

Предположим можно сказать: красивую графику, реалистичное освещение. Пожалуй всё. Нет? А по моему там больше увидить нечего! В нём как и во многих играх текущего поколения рассматривается скудность возможностей 9 директаИкса.

DirectX 10 есть то что поможет играм стать по прежнему любимымы для геймеров, сечас наступает момент когда преход на новое и неизвесное, но давольно ожидаемое "графическое ядро" просто необходим. Посмотри во что играли люди 5, 10, 15, 20 лет назад. Представь каково было бы играть в те игры увидив графику текущего поколения.

...Представил?

Если нет, то заставь меня поверить твоим словам.

Посмотри на The Elder Scrolls 4: Oblivion. Что ты видишь?

Предположим можно сказать: красивую графику, реалистичное освещение. Пожалуй всё. Нет? А по моему там больше увидить нечего! В нём как и во многих играх текущего поколения рассматривается скудность возможностей 9 директаИкса.

DirectX 10 есть то что поможет играм стать по прежнему любимымы для геймеров, сечас наступает момент когда преход на новое и неизвесное, но давольно ожидаемое "графическое ядро" просто необходим. Посмотри во что играли люди 5, 10, 15, 20 лет назад. Представь каково было бы играть в те игры увидив графику текущего поколения.

...Представил?

Если нет, то заставь меня поверить твоим словам.

Hint,

И согласен и нет.

Так как смотря интервью опять же уже не с безызвестным Кризисом. Слышу коммент:

- Это все вы видите на 9ДХ, на видеокарте х1900.

Первая мысль (не буду говорить правила не позволят), но меня вполне устраивает эта графика, освещение и т.д. Зачем платить больше?

А дальше пойдет Дх11, а ДХ12 вообще будет бомба, превращающий игру в настоящую жизнь, без границ. Ты видел под 10 ДХ на банке с пивом надпись 1-ым шрифтом "Лучшее пиво Гондураса"? Нет? Поставьте 12ДХ и вы увидите не только это.

Не соглашусь, так как многим на графику плевать, главное, что был увлекательный сюжет.

Цитата

DirectX 10 есть то что поможет играм стать по прежнему любимымы для геймеров, сечас наступает момент когда преход на новое и неизвесное, но давольно ожидаемое "графическое ядро" просто необходим.

И согласен и нет.

Так как смотря интервью опять же уже не с безызвестным Кризисом. Слышу коммент:

- Это все вы видите на 9ДХ, на видеокарте х1900.

Первая мысль (не буду говорить правила не позволят), но меня вполне устраивает эта графика, освещение и т.д. Зачем платить больше?

А дальше пойдет Дх11, а ДХ12 вообще будет бомба, превращающий игру в настоящую жизнь, без границ. Ты видел под 10 ДХ на банке с пивом надпись 1-ым шрифтом "Лучшее пиво Гондураса"? Нет? Поставьте 12ДХ и вы увидите не только это.

Цитата

Посмотри во что играли люди 5, 10, 15, 20 лет назад

Не соглашусь, так как многим на графику плевать, главное, что был увлекательный сюжет.

Цитата

Не соглашусь, так как многим на графику плевать, главное, что был увлекательный сюжет.

Плевать не плевать а выйди например ХЛ2 на движке первого , так она бы и провалилась в первый день...и не спасла бы ее ни сюжет и ни атмосфера...

Цитата

Зачем платить больше?

Нi - end система под дх 9 будет стоить ни чуть не дешевле чем под дх 10.

А примерно когда дх10 карты выйдут ? в этом году или следующем?

G80 если не задержится, то летом

На крайняк к началу осени.

На крайняк к началу осени.

Hint, то есть этим летом или в сентябре-ноябре появится в продаже ?

Illidian,

Скорее ближе к новому году.

И то, только для того, чтобы составить конкуренцию R580+.

Раньше выпускать смысла нет, VISTA выйдет только в следующем году, которая нужна, чтобы задействовать все возможности видеокарты (DX10).

Цитата

то есть этим летом или в сентябре-ноябре появится в продаже ?????

Скорее ближе к новому году.

И то, только для того, чтобы составить конкуренцию R580+.

Раньше выпускать смысла нет, VISTA выйдет только в следующем году, которая нужна, чтобы задействовать все возможности видеокарты (DX10).

Цитата

R580+

Это же не дх10 решение, а к зиме ну никак не выйдет, зима - время r600.

G80 будет бысрее G71 (если в расчёт брать дх 9) и мее "голдный".

Так что выйдет

Цитата

летом или в сентябре-ноябре

2006 года.

R580+ выходит в ]]>]]> NVIDIA, кроме дорогой GF 7950, противопоставить ему нечего, но это ей и не нужно. Она выпустит G80 и убъет двух зайцев:

опять примет лавры первенства (выпустив более производительное решение)

первая выпустит чип, поддерживающий DX10.

Но сначала будет доминировать 1 пункт потому, что задействовать возможности DX10 пользователи смогут только с выходом Windows Vista.

Поэтому особо торопиться NVIDIA не станет, доведет до ума техпроцесс и выпустит G80 ближе к новому году (раньше бессмысленно).

опять примет лавры первенства (выпустив более производительное решение)

первая выпустит чип, поддерживающий DX10.

Но сначала будет доминировать 1 пункт потому, что задействовать возможности DX10 пользователи смогут только с выходом Windows Vista.

Поэтому особо торопиться NVIDIA не станет, доведет до ума техпроцесс и выпустит G80 ближе к новому году (раньше бессмысленно).

R580+ выходит в ]]>]]> NVIDIA, кроме дорогой GF 7950GX2, противопоставить ему нечего, но это ей и не нужно. Она выпустит G80 и убъет двух зайцев:

опять примет лавры первенства (выпустив более производительное решение)

первая выпустит чип, поддерживающий DX10.

Но сначала будет доминировать 1 пункт потому, что задействовать возможности DX10 пользователи смогут только с выходом Windows Vista.

Поэтому особо торопиться NVIDIA не станет, доведет до ума техпроцесс и выпустит G80 ближе к новому году (раньше бессмысленно).

опять примет лавры первенства (выпустив более производительное решение)

первая выпустит чип, поддерживающий DX10.

Но сначала будет доминировать 1 пункт потому, что задействовать возможности DX10 пользователи смогут только с выходом Windows Vista.

Поэтому особо торопиться NVIDIA не станет, доведет до ума техпроцесс и выпустит G80 ближе к новому году (раньше бессмысленно).

Zeed,

Есть смысл. Чип будет быстрее и дешевле.

Нвидия выпустит G80 за 6 - 4 до R600.

Was added in 1 minute 31 seconds:

И доробатывать там почти нечего, на 80 или 65 нм G80 не переведут.

Есть смысл. Чип будет быстрее и дешевле.

Нвидия выпустит G80 за 6 - 4 до R600.

Was added in 1 minute 31 seconds:

И доробатывать там почти нечего, на 80 или 65 нм G80 не переведут.

Hint,

Существующих аналогов от ATI? Это я уже писал ранее.

Это я уже писал ранее.

И никто не спорит, что он выйдет быстрее R600.

Но говорить

не совсем корректно (летом уж точно не выйдет), скорее - в конце ноября-декабре.

Да и чего сейчас рассуждать о том, когда он выйдет? Все равно

А я, к тому же (как и большинство, я думаю), подожду G83 или аналог от ATI (что будет быстрее и дешевле, то и возьму).

Дорабатывать всегда есть что, такой сложный чип не возможен без некоторых ошибок (разработчики тоже люди ). Иначе все чипы были бы первой ревизии, на практике - в серийное производство идет, в лучшем случае, 2-я - 3-я.

). Иначе все чипы были бы первой ревизии, на практике - в серийное производство идет, в лучшем случае, 2-я - 3-я.

Цитата

Есть смысл. Чип будет быстрее и дешевле.

Существующих аналогов от ATI?

И никто не спорит, что он выйдет быстрее R600.

Но говорить

Цитата

Так что выйдет

Цитата

летом или в сентябре-ноябре

не совсем корректно (летом уж точно не выйдет), скорее - в конце ноября-декабре.

Да и чего сейчас рассуждать о том, когда он выйдет? Все равно

Цитата

задействовать возможности DX10 пользователи смогут только с выходом Windows Vista.

А я, к тому же (как и большинство, я думаю), подожду G83 или аналог от ATI (что будет быстрее и дешевле, то и возьму).

Цитата

И доробатывать там почти нечего, на 80 или 65 нм G80 не переведут.

Дорабатывать всегда есть что, такой сложный чип не возможен без некоторых ошибок (разработчики тоже люди

Цитата

подожду G83

Ты чё будешь ждать пару лет?

G71 повился где то через год после G70.

Я тоже не собираюсь брать карточки из первого потока, если они конечно не будут стоить по 200 - 300 usd. Возьму только от ATI.

Цитата

не совсем корректно (летом уж точно не выйдет), скорее - в конце ноября-декабре

Ну где хоть одно "за" в твою сторону? Да и мне тоже нечем подтвердить.

Предлагаю прекратить спор.

Появится инфа - появится диолог.

Hint,

Ты меня не понял. По аналогии - G73 (GF 7600## ) -> G83 (GF8600##).

По аналогии - G73 (GF 7600## ) -> G83 (GF8600##).

Тут я буду придерживаться политики

"За" были выше, да и на рождественские праздники покупательская активность населения резко возрастает.

Согласен, спор ни о чем.

Цитата

Ты чё будешь ждать пару лет?

G71 повился где то через год после G70.

G71 повился где то через год после G70.

Ты меня не понял.

Цитата

подожду G83 или аналог от ATI (что будет быстрее и дешевле, то и возьму).

Тут я буду придерживаться политики

Цитата

быстрее и дешевле

Цитата

Ну где хоть одно "за" в твою сторону?

"За" были выше, да и на рождественские праздники покупательская активность населения резко возрастает.

Цитата

Предлагаю прекратить спор.

Согласен, спор ни о чем.

]]>]]>

Так, начнём с обьёма памяти:

Чипов памяти 12 (в одном распологается 64 мб памяти), следовательно память будет в обьёме не менее 768 Мб.

Система охлажения у 8800GTX по слухам будет гибритной - воздух + вода:

А у 8800GT только вождушная СО:

Видимо эненергопотребление в 175 Вт и частота ядра до 1.5 ГГц + DDR4 и унифицированные конвееры будут обеспечены .

ИМХО это ну никак не окончатильный вариат G80 видюхи, ибо размер в 280 х 127 х 42 мм говорит и нереальности использования в большенстве сис. блоков.

Ещё интересует предназначение звуковой монофонической "колонки" в правой части видеокарты

Чипов памяти 12 (в одном распологается 64 мб памяти), следовательно память будет в обьёме не менее 768 Мб.

Система охлажения у 8800GTX по слухам будет гибритной - воздух + вода:

А у 8800GT только вождушная СО:

Видимо эненергопотребление в 175 Вт и частота ядра до 1.5 ГГц + DDR4 и унифицированные конвееры будут обеспечены .

ИМХО это ну никак не окончатильный вариат G80 видюхи, ибо размер в 280 х 127 х 42 мм говорит и нереальности использования в большенстве сис. блоков.

Ещё интересует предназначение звуковой монофонической "колонки" в правой части видеокарты

Hint, она наверное орать будет при проблемах охлаждения.

Да, разумеется не удасться сделать разгон без СВО, американская компания не зачно не станет увеличивать размеры куллера, она просто сделает стандартным вращением вентилятора, ну предположим на 6000 оборотах в минуту. А подругому никак, хочешь топовую видеокарту - приобритай СВО, а то как то не солидно будет сидеть с 8800GTХ и на воздухе.

Так что подумайте прежде чем копить на G80 .

.

глюкнутый пост, всем сорри

Так что подумайте прежде чем копить на G80

глюкнутый пост, всем сорри

тест

Флагманский чип NVIDIA G80 выйдет в середине ноября

]]>]]>

Цитата

Появившиеся в конце прошлой недели фотографии эталонных видеокарт на базе видеочипа NVIDIA G80 наделали много шума. Даже самые закоренелые скептики, верующие во всемогущий Photoshop, оставляли мало сомнений по поводу достоверности опубликованных фотографий.

Из прочих данных, полученных одновременно с фотографиями, следует упомянуть наличие на видеокарте памяти типа GDDR-4. Её расположение в виде буквы "П" позволяет предположить, что G80 будет использовать 384-битный доступ к памяти вместо традиционного 256-битного. Система охлаждения G80, судя по представленным фотографиям, может иметь два конструктивных исполнения: гибридное (жидкостное + воздушное) и чисто воздушное. Не факт, что гибридный вариант появится на серийных видеокартах.

Сегодня известный тайваньский сайт DigiTimes со ссылкой на местных производителей сообщил, что анонс G80 всё же состоится в середине ноября этого года. Видеокарты получат обозначение вида "GeForce 8800" и поддержку DirectX 10. Коллеги считают, что последнее свойство данных видеокарт привяжет их популярность к степени доступности операционной системы Windows Vista и игр с поддержкой этого API. Как известно, без Windows Vista нельзя работать с DirectX 10. Эта точка зрения не учитывает того факта, что G80 может работать и с DirectX 9.0c. Пока факт использования чипом G80 унифицированной шейдерной архитектуры не доказан. Скорее, наоборот - представители NVIDIA ранее старались откреститься от резкого перехода на унифицированную шейдерную архитектуру, и относительно ранний анонс G80 в какой-то мере указывает на то, что NVIDIA уверена в конкурентоспособности нового продукта в существующей среде, подразумевающей использование DirectX 9.0c.

Тайваньские производители выразили сомнения в возможности выхода конкурирующего видеочипа R600 от ATI в текущем году. Коллеги с сайта The Inquirer сообщают, что чип R600 будет иметь 500 млн. транзисторов - свой вклад в формирование этой цифры сделали поддержка DirectX 10 и унифицированная шейдерная архитектура. Британские коллеги уверены, что R600 будет быстр и в DirectX 10, и в DirectX 9.0c. Более того, тесные отношения ATI с Microsoft могут давать первой преимущества в сфере оптимизации драйверов.

Из прочих данных, полученных одновременно с фотографиями, следует упомянуть наличие на видеокарте памяти типа GDDR-4. Её расположение в виде буквы "П" позволяет предположить, что G80 будет использовать 384-битный доступ к памяти вместо традиционного 256-битного. Система охлаждения G80, судя по представленным фотографиям, может иметь два конструктивных исполнения: гибридное (жидкостное + воздушное) и чисто воздушное. Не факт, что гибридный вариант появится на серийных видеокартах.

Сегодня известный тайваньский сайт DigiTimes со ссылкой на местных производителей сообщил, что анонс G80 всё же состоится в середине ноября этого года. Видеокарты получат обозначение вида "GeForce 8800" и поддержку DirectX 10. Коллеги считают, что последнее свойство данных видеокарт привяжет их популярность к степени доступности операционной системы Windows Vista и игр с поддержкой этого API. Как известно, без Windows Vista нельзя работать с DirectX 10. Эта точка зрения не учитывает того факта, что G80 может работать и с DirectX 9.0c. Пока факт использования чипом G80 унифицированной шейдерной архитектуры не доказан. Скорее, наоборот - представители NVIDIA ранее старались откреститься от резкого перехода на унифицированную шейдерную архитектуру, и относительно ранний анонс G80 в какой-то мере указывает на то, что NVIDIA уверена в конкурентоспособности нового продукта в существующей среде, подразумевающей использование DirectX 9.0c.

Тайваньские производители выразили сомнения в возможности выхода конкурирующего видеочипа R600 от ATI в текущем году. Коллеги с сайта The Inquirer сообщают, что чип R600 будет иметь 500 млн. транзисторов - свой вклад в формирование этой цифры сделали поддержка DirectX 10 и унифицированная шейдерная архитектура. Британские коллеги уверены, что R600 будет быстр и в DirectX 10, и в DirectX 9.0c. Более того, тесные отношения ATI с Microsoft могут давать первой преимущества в сфере оптимизации драйверов.

]]>]]>

Характеристики GeForce 8800 GTX и GeForce 8800 GTS, а также поддержка "физики"

]]>]]>

Цитата

. Выдавать информацию об очередных флагманах NVIDIA нужно "по чайной ложке", чтобы у изголодавшейся публики не появились признаки перенасыщения. Впрочем, в данном случае уместно было бы говорить о тепловом ударе или обмороке от знакомства со счетами за электричество  .

.

В общем, так указанный американский сайт и поступил. Сегодня он поведал о характеристиках видеокарт GeForce 8800 GTX и GeForce 8800 GTS, которые наконец обрели чёткие очертания - анонс соответствующих продуктов намечен на вторую неделю ноября. Кстати, доступность видеокарт в рознице, по уже сложившейся хорошей традиции, будет незамедлительной: утром анонс - вечером видеокарты, или наоборот.

Итак, начнём с флагмана по имени GeForce 8800 GTX:

Частота видеочипа 575 МГц. Что характерно, 128 унифицированных шейдерных блоков будут работать на частоте 1350 МГц. Как видите, стратегия дифференцированного назначения тактовых частот для разных функциональных блоков внутри видеочипа продолжает работать.

Частота памяти 1800 МГц DDR. Самое забавное, что вместо вполне естественной для нынешнего сезона GDDR-4 мы увидим на GeForce 8800 GTX память типа GDDR-3. По крайней мере, в этом уверены американские коллеги.

Ответ на вопрос "почему не GDDR-4?" даёт описание объёма памяти GeForce 8800 GTX - видеокарта будет иметь 768 Мб памяти. То есть, к обычным 512 Мб добавлены ещё 256 Мб - скорее всего, для нужд обработки физических эффектов или прочих специфических задач. Если бы GeForce 8800 GTX использовала память GDDR-4 такого объёма, цена получилась бы не самой привлекательной.

Шина памяти тоже имеет необычную разрядность - 384 бит. То есть, к обычным 256 битам добавлены ещё 128 бит. Это объясняет П-образное размещение микросхем памяти вокруг видеочипа на графической карте GeForce 8800 GTX.

Наконец, пара скоростных характеристик: память обеспечивает пропускную способность 86 Гбит/с, видеочип заполняет сцену со скоростью 38.4 млрд. пикселей в секунду.

Вторая видеокарта семейства по имени GeForce 8800 GTS отличается более скромными характеристиками:

Частота чипа 500 МГц.

96 унифицированных шейдерных блоков, работающих на частоте 1200 МГц.

Частота памяти 1800 МГц DDR.

640 Мб памяти типа GDDR-3 (512 + 128).

320-битная шина памяти (256 + 64).

Пропускная способность памяти 64 Гбит/с.

Остаётся добавить, что обе видеокарты будут поддерживать DirectX 10 и Shader Model 4.0, а также Dual-Link DVI, HDCP, VIVO и HDTV. О требованиях по мощности блока питания для этих видеокарт мы уже сегодня рассказывали.

Вторая новость с сайта DailyTech гласит о том, что видеокарты на базе чипа G80 будут поддерживать ускорение "физики" на аппаратном уровне. В рамках технологии, называемой Quantum Effects (название может быть изменено в окончательном варианте), подразумевается использование части унифицированных шейдерных блоков видеочипа G80 для расчёта физических эффектов. Собственно говоря, это подтверждает озвученные ранее данные об особенностях работы G80 с "физическими" эффектами.

Можно предположить, что те самые "дополнительные" мегабайты памяти и "кусочки" шины памяти нужны G80 как раз для работы с "физикой". Впрочем, при отсутствии явно выраженной "физической нагрузки" они вряд ли будут простаивать без дела или как-то отделяться от остальных ресурсов видеокарты.

Следует отметить, что "физическая" технология от NVIDIA может работать и без SLI, на одиночной видеокарте. NVIDIA даёт понять, что Quantum будет конкурировать с AGEIA PhysX, но о разработчике "своего" физического движка скромно умалчивает. Впрочем, угадать его имя не так сложно - очевидно, это Havok, ибо это основная конкурирующая с AGEIA PhysX "физическая" платформа.

В общем, так указанный американский сайт и поступил. Сегодня он поведал о характеристиках видеокарт GeForce 8800 GTX и GeForce 8800 GTS, которые наконец обрели чёткие очертания - анонс соответствующих продуктов намечен на вторую неделю ноября. Кстати, доступность видеокарт в рознице, по уже сложившейся хорошей традиции, будет незамедлительной: утром анонс - вечером видеокарты, или наоборот.

Итак, начнём с флагмана по имени GeForce 8800 GTX:

Частота видеочипа 575 МГц. Что характерно, 128 унифицированных шейдерных блоков будут работать на частоте 1350 МГц. Как видите, стратегия дифференцированного назначения тактовых частот для разных функциональных блоков внутри видеочипа продолжает работать.

Частота памяти 1800 МГц DDR. Самое забавное, что вместо вполне естественной для нынешнего сезона GDDR-4 мы увидим на GeForce 8800 GTX память типа GDDR-3. По крайней мере, в этом уверены американские коллеги.

Ответ на вопрос "почему не GDDR-4?" даёт описание объёма памяти GeForce 8800 GTX - видеокарта будет иметь 768 Мб памяти. То есть, к обычным 512 Мб добавлены ещё 256 Мб - скорее всего, для нужд обработки физических эффектов или прочих специфических задач. Если бы GeForce 8800 GTX использовала память GDDR-4 такого объёма, цена получилась бы не самой привлекательной.

Шина памяти тоже имеет необычную разрядность - 384 бит. То есть, к обычным 256 битам добавлены ещё 128 бит. Это объясняет П-образное размещение микросхем памяти вокруг видеочипа на графической карте GeForce 8800 GTX.

Наконец, пара скоростных характеристик: память обеспечивает пропускную способность 86 Гбит/с, видеочип заполняет сцену со скоростью 38.4 млрд. пикселей в секунду.

Вторая видеокарта семейства по имени GeForce 8800 GTS отличается более скромными характеристиками:

Частота чипа 500 МГц.

96 унифицированных шейдерных блоков, работающих на частоте 1200 МГц.

Частота памяти 1800 МГц DDR.

640 Мб памяти типа GDDR-3 (512 + 128).

320-битная шина памяти (256 + 64).

Пропускная способность памяти 64 Гбит/с.

Остаётся добавить, что обе видеокарты будут поддерживать DirectX 10 и Shader Model 4.0, а также Dual-Link DVI, HDCP, VIVO и HDTV. О требованиях по мощности блока питания для этих видеокарт мы уже сегодня рассказывали.

Вторая новость с сайта DailyTech гласит о том, что видеокарты на базе чипа G80 будут поддерживать ускорение "физики" на аппаратном уровне. В рамках технологии, называемой Quantum Effects (название может быть изменено в окончательном варианте), подразумевается использование части унифицированных шейдерных блоков видеочипа G80 для расчёта физических эффектов. Собственно говоря, это подтверждает озвученные ранее данные об особенностях работы G80 с "физическими" эффектами.

Можно предположить, что те самые "дополнительные" мегабайты памяти и "кусочки" шины памяти нужны G80 как раз для работы с "физикой". Впрочем, при отсутствии явно выраженной "физической нагрузки" они вряд ли будут простаивать без дела или как-то отделяться от остальных ресурсов видеокарты.

Следует отметить, что "физическая" технология от NVIDIA может работать и без SLI, на одиночной видеокарте. NVIDIA даёт понять, что Quantum будет конкурировать с AGEIA PhysX, но о разработчике "своего" физического движка скромно умалчивает. Впрочем, угадать его имя не так сложно - очевидно, это Havok, ибо это основная конкурирующая с AGEIA PhysX "физическая" платформа.

]]>]]>

Rezak тока растравил,млин слюни текут,полюбас в следующем году буду брать,а иначе всех красот Кризиса не увидим

-=[Patr1ck]=-,

Во превых, хочу сказать, что сейчас игра двигается на х1900хтх, будет крайсис - будет софт для улучшения гравики под видеокарты нынешнего поколения. Но всё же проблема остаётся в архетектуре самого GPU дх9, на 7950gx2 точно будет такой софт который будет тянуть, пусть даже эмулятор дх 10. Для того и создаётяс новейшее железо, которое портят карявые драйвера и биосы.

И во вторых, мир не остановился на крайсисе.

Во превых, хочу сказать, что сейчас игра двигается на х1900хтх, будет крайсис - будет софт для улучшения гравики под видеокарты нынешнего поколения. Но всё же проблема остаётся в архетектуре самого GPU дх9, на 7950gx2 точно будет такой софт который будет тянуть, пусть даже эмулятор дх 10. Для того и создаётяс новейшее железо, которое портят карявые драйвера и биосы.

И во вторых, мир не остановился на крайсисе.

Я всё хотел спросить а не будет ли возможности хоть небольшого перехода на Dx 10 видеокарт под которые он не был разчитан? А собсно реч идет о 7600 GT?

Vitriks, Размечтался , нет конечно

Для просмотра полной версии этой страницы, пожалуйста, пройдите по ссылке.