Полная версия этой страницы: Железная флудилка

Страницы: 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40, 41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72

Berkut107, смотри тесты и решай. Лучше брать процессор на Zen2 или как минимум на Zen+.

Всем привет. Хочу поставить новый проц, но имею не большой бюджет. Сейчас сижу на r3 2200g, стоит ли брать в 2020 году r7 1700? Вроде по тестам лучше чем р5 2600. Или лучше подкопить до р7 2700? Брать собираюсь на б/у либо али. На али не плохой вариант есть r7 PRO 1700 за 7300₽.

Бери Ryzen 5 3600.

Переплатить в 2 раза? Когда я за 7 тысяч, могу взять 8 ядерный камень вместо 6, так еще и в играх я посмотрел 1700 по шустрее будет на чуть-чуть совсем правда. Да и в прогах 8/16 мне кажется по лучше будет.

Где это 1700 обходит 3600?

И пока 16 потоков 1700го станут актуальными, он уже устареет по остальным характеристикам. Либо гнать до усрачки, либо брать 2700Х или лучше 3700Х

1700 норм только за дёшево и с разгоном 3.6-3.8 ггц. Ryzen Pro вроде не разгоняется.

Zen 3 не за горами. Я-б хапнул дешёвый 1600 и на нём пересидел ещё пол года, будет очень заметно шустрее, чем 1200, в играх он почти как 1700. В разгоне в играх они почти одинаковые. 3300Х тоже шустряк, но у него проблемы с доступностью. Для игор на близжайшие пол года я бы предпочёл 3300Х, а не 1700.

В некоторых играх GeForce RTX 3090 будет в два раза производительнее GeForce RTX 2080 Ti

Официальный анонс графических карт NVIDIA GeForce RTX 30-й серии на базе новой микроархитектуры Ampere ожидается только завтра. Однако в Сети уже опубликована информация, которая сообщает о том, какого уровня игровой производительности стоит ожидать от флагмана новой серии — модели GeForce RTX 3090.

В распоряжении ресурса TechPowerUp оказался презентационный слайд компании NVIDIA, на котором указан уровень прироста производительности GeForce RTX 3090 по отношению к актуальному потребительскому флагману NVIDIA GeForce RTX 2080 Ti.

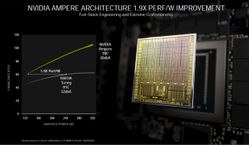

На графике показаны результаты испытаний в таких играх, как Minecraft RTX, Сontrol и Wolfenstein: Young Blood. Проверка проводилась в разрешении 4K при включённом интеллектуальном ИИ-сглаживания DLSS. В Minecraft RTX производительность GeForce RTX 3090 оказалась на 100% выше, чем у RTX 2080 Ti. В Control ситуация даже лучше. В Wolfenstein: Young Blood превосходство нового флагмана над актуальным RTX 2080 Ti чуть-чуть не дотянуло до значения 80%.

Официальный анонс графических карт NVIDIA GeForce RTX 30-й серии на базе новой микроархитектуры Ampere ожидается только завтра. Однако в Сети уже опубликована информация, которая сообщает о том, какого уровня игровой производительности стоит ожидать от флагмана новой серии — модели GeForce RTX 3090.

В распоряжении ресурса TechPowerUp оказался презентационный слайд компании NVIDIA, на котором указан уровень прироста производительности GeForce RTX 3090 по отношению к актуальному потребительскому флагману NVIDIA GeForce RTX 2080 Ti.

На графике показаны результаты испытаний в таких играх, как Minecraft RTX, Сontrol и Wolfenstein: Young Blood. Проверка проводилась в разрешении 4K при включённом интеллектуальном ИИ-сглаживания DLSS. В Minecraft RTX производительность GeForce RTX 3090 оказалась на 100% выше, чем у RTX 2080 Ti. В Control ситуация даже лучше. В Wolfenstein: Young Blood превосходство нового флагмана над актуальным RTX 2080 Ti чуть-чуть не дотянуло до значения 80%.

Проверка проводилась в разрешении 4K при включённом интеллектуальном ИИ-сглаживания DLSS. В Minecraft RTX производительность GeForce RTX 3090 оказалась на 100% выше, чем у RTX 2080 Ti. В Control ситуация даже лучше. В Wolfenstein: Young Blood превосходство нового флагмана над актуальным RTX 2080 Ti чуть-чуть не дотянуло до значения 80%.

Чёт не очень. Маскируют прирост производительности с помощью DLSS.

Учитывая, что очень немногие игори воспользовались DLSS в течении двух лет после выхода КЕЧ, я щитаю эти тесты неполноценными и как-бэ лживыми. Но есть слухи, что DLSS будет более доступен для разработчиков. Сейчас почему-то Nvidia активно мешает разработчикам внедрять DLSS в свои игры - в открытом доступе технологии нет. Nvidiots.

Были слухи о 3-5 кратном увеличении RT производительности в Minecraft RTX, видимо на деле там суммарно 2-кратно от комбинации улучшений мощностей, архитектуры и DLSS. Как то не очень.

Посмотрим на абзоры и цены в магазинах. Я так думаю, 1080 TI останется актуальной до тех пор пока VRS и другие DX12_2 фичи не станут широко распространёнными в ААА игорях, т.е. минимум до осени следующего года, а там уж MCM (многочиповые) карточки не за горами.

Nvidia конечно знатно прострелили себе ногу с помощью 1080 TI. С тех пор выпустили ещё 3 карты на уровне около 1080 TI - 2070, 2070 SU, 2080.

Ещё смешно про RTX Voice - программа, которая "с помощью тензорных ядер в чипах Turing" убирает фоновый шум.

Берёшь пакет установки, открываешь конфиг, удаляешь секцию "ограничения" и RTX Voice ставится и работает на компе не то что без Nvidia RTX, так вообще без карты Nvidia. Польза от тензорных ядер аж из всех щелей:

Берёшь пакет установки, открываешь конфиг, удаляешь секцию "ограничения" и RTX Voice ставится и работает на компе не то что без Nvidia RTX, так вообще без карты Nvidia. Польза от тензорных ядер аж из всех щелей: Nvidia RTX Voice

Обратная совместимость была добавлена, как слышал, теми кто программировал тупо "потому что могли", а так и качество обработки лучше и нагрузка на карту ниже на RTX, при том ощутимо. На моей 1070 Ti RTX Voice начинает захлёбываться через каких-то десять минут, то пропуская слова, то внезапно забивая оперативку и т.д. и т.п., особенно если ещё чем-то карту грузить. У друга на 2060 часами работает. Зависть

.

36 терафлопсов за 1.5К баксев, неплохо. 10 с половиной тыщ CUDA. 3х прирост производительности за 3 года, пусть и увеличением цены. Nvidia спустились с облаков на землю.

Все утечки ошиблись в 2 раза по кол-ву CUDA.

F in chat всем, кто относительно недавно купил КЕЧ 2000.

Все утечки ошиблись в 2 раза по кол-ву CUDA.

F in chat всем, кто относительно недавно купил КЕЧ 2000.

Всем привет. Хочу поставить новый проц, но имею не большой бюджет. Сейчас сижу на r3 2200g, стоит ли брать в 2020 году r7 1700? Вроде по тестам лучше чем р5 2600. Или лучше подкопить до р7 2700? Брать собираюсь на б/у либо али. На али не плохой вариант есть r7 PRO 1700 за 7300₽.

Бери Ryzen 5 3600.

Переплатить в 2 раза? Когда я за 7 тысяч, могу взять 8 ядерный камень вместо 6, так еще и в играх я посмотрел 1700 по шустрее будет на чуть-чуть совсем правда. Да и в прогах 8/16 мне кажется по лучше будет.

Где это 1700 обходит 3600?

И пока 16 потоков 1700го станут актуальными, он уже устареет по остальным характеристикам. Либо гнать до усрачки, либо брать 2700Х или лучше 3700Х

1700 норм только за дёшево и с разгоном 3.6-3.8 ггц. Ryzen Pro вроде не разгоняется.

Видел на форумах, гонят PRO версии, хотя везде пишут, что не гонятся. Я вообще не вижу смысла брать Ховые версии процов, ибо разогнать могу сам.

Zen 3 не за горами. Я-б хапнул дешёвый 1600 и на нём пересидел ещё пол года, будет очень заметно шустрее, чем 1200, в играх он почти как 1700. В разгоне в играх они почти одинаковые. 3300Х тоже шустряк, но у него проблемы с доступностью. Для игор на близжайшие пол года я бы предпочёл 3300Х, а не 1700.

Хм, а смогут-ли AMD в 600мм2 графический чип с 8192 шейдерными блоками?)))

Надо поматанить 505мм2 карту с плотностью 6мм2 на CU.

Надо поматанить 505мм2 карту с плотностью 6мм2 на CU.

F in chat всем, кто относительно недавно купил КЕЧ 2000.

Ну я не переживаю вообще, новый комп уже отбил свои деньги, а к нг как появятся интересные и стабильные 30xx, можно спокойно обновиться.

Ну одно дело, когда отбивают. Совсем другое, когда только только прожирают деньги

На не подгружается вторая для сравнения картинка, и кажется что нету никакой разницы в графике.

Такс, теперь вроде есть инфа, что в Ampere, одно CUDA "ядро" делает в двое больше FP32 матанов за такт, чем Turing. Так что ядер на самом деле не 10 тыщ, просто так нарисовали в спецификациях. Но пока всё равно нипонятно, шо творисся. Ждём бенчмарков.

Cossack-HD,

Цитата

Я так думаю, 1080 TI останется актуальной до тех пор пока VRS и другие DX12_2 фичи не станут широко распространёнными в ААА игорях

Для full hd до 4 поколения точно актуальна будет, а то и до 5. Она в 2.5 раза мощнее rx 580 моей, а мне это карты пока хватает, что бы подвигать ползунки в настройках и играть в игрухи спокойно. По этому можно подождать ща, пока на авито упадут цены косарей до 15-17 и брать, после того как на вторую серию цены начали падать на вторичке.

Смотрел презентацию новых видеокарт.

Да, Хуанг на своей кухне умеет готовить. Тут ничего и не скажешь.

Очевидно линейка видеокарт удалась. Топ в лице 3090 по ходу заменит титаны и будет больше для разработчиков, так как характеристики не так уж сильно ушли от 3080 вперёд , а цена скаканула прилично. Там только видеопамять соответствует статусу, но не количество вычислительных единиц, скажем так.

По итогу можно сказать, что 3080 офигенная карточка и это реальная замена допустим моему топовому паскалю (1080Ti).

Так же очень аппетитна 3070. Она равна по производительности 2080Ti, а значит обладатели 1080, 2070 и ниже уже могут на неё переходить и получить заметный буст.

Поздравляю Нвидиа и всех нас.

Да, Хуанг на своей кухне умеет готовить. Тут ничего и не скажешь.

Очевидно линейка видеокарт удалась. Топ в лице 3090 по ходу заменит титаны и будет больше для разработчиков, так как характеристики не так уж сильно ушли от 3080 вперёд , а цена скаканула прилично. Там только видеопамять соответствует статусу, но не количество вычислительных единиц, скажем так.

По итогу можно сказать, что 3080 офигенная карточка и это реальная замена допустим моему топовому паскалю (1080Ti).

Так же очень аппетитна 3070. Она равна по производительности 2080Ti, а значит обладатели 1080, 2070 и ниже уже могут на неё переходить и получить заметный буст.

Поздравляю Нвидиа и всех нас.

Ах да.

Конечно ещё интересен ответ от АМД в лице Big Navi. По идее тоже должны приятно удивить.

Здоровая конкуренция всегда хорошо. Глядишь и цены снизятся немного, хотя в реале вряд ли это произойдёт. Скорее АМД поднимем ценовую планку. Ну типа вот мы (с Нвидиа вместе) вам предлагаем отличные видеокарты по 700 баксов для гейминга в 4К и на этом точка.

Конечно ещё интересен ответ от АМД в лице Big Navi. По идее тоже должны приятно удивить.

Здоровая конкуренция всегда хорошо. Глядишь и цены снизятся немного, хотя в реале вряд ли это произойдёт. Скорее АМД поднимем ценовую планку. Ну типа вот мы (с Нвидиа вместе) вам предлагаем отличные видеокарты по 700 баксов для гейминга в 4К и на этом точка.

Больше информации о новой серии видеокарт, NVIDIA ответила на вопросы сообщества:

И из соседней новости про водоблоки:

Я всегда думал, что Founders Edition основаны на референсном дизайне плат.

И из соседней новости про водоблоки:

Цитата

EK warning: This block is made for reference PCB 3080 and 3090 cards. Founders Edition does NOT have a reference PCB.

Я всегда думал, что Founders Edition основаны на референсном дизайне плат.

Samsung представила SSD со скоростью до 6500 МБ/с

Южнокорейский гигант Samsung на выставке CES 2020 представил M.2 NVMe SSD с рекордными скоростными характеристиками.

Накопитель Samsung 980 Pro, предназначенный для шины PCIe Gen4, обеспечивает скорость последовательного чтения на уровне до 6,5 ГБ/с, а последовательной записи — 5 ГБ/с. Для достижения этих скоростей компания разработала собственный контроллер и улучшила память 3D-V-NAND для обеспечения большей энергоэффективности. Повысить скорость доступа к памяти удалось за счёт увеличения стека V-NAND до 128 слоёв.

К сожалению, Samsung не предоставила более подробную информацию о модели 980 Pro. Известно лишь, что она будет доступна в вариантах объёмом 250 ГБ, 500 ГБ и 1 ТБ. Накопители Samsung 980 Pro SSD будут выпущены 21 января в США и Южной Корее. Весь остальной мир увидит их в феврале.

Поздравлять никого не буду с этим событием, поскольку Самсунг умудрилась поднасрать потребителям и засунула в PRO линейку память TLC.

Раньше все любили и отдавали свои деньги за серию PRO в первую очередь за память MLC ведь у неё ресурс в два раза выше.

Всё, теперь и они перешли на сторону зла.

Но тут не надо думать, что я сижу и ворчу и дуюсь как старпёр какой-нибудь. Просто мне не нравится такой ход с их стороны. Назвали бы EVO и вопросов с претензиями бы не было.

В общем у кого есть деньги, то бегите в магазин за 970 PRO пока они ещё есть.

Согласен.

Решил перечитать обзоры и вспомнить: |

Цитата

SSD PCIe 4.0 NVMe: ,

Решил перечитать обзоры и вспомнить: |

Добавлю.

Я думаю Самсунг перевела PRO линейку на память TLC исходя из того, что EVO будет на QLC.

Таким образом мы наблюдаем общее падение...

Наверное это продиктовано рынком и возможно техническими нюансами.

Мы и все потребители подстроимся под новые реалии, ведь другого пути не видно. Ничего. Можно менять или обновлять накопители примерно раз в 4-5 лет.

Хотя мой Crucial m4 128gb работает в качестве системно-игрового уже восьмой год.

Конечно в профиле у меня указан 860EVO 500Gb, но он для увесистых современных игр + то, что должно быть под рукой и немного семейного архива, хотя последний конечно продублирован на классическом HDD, ведь длительное хранение информации лучше осуществлять на "блинах" (при этом желательно меньше динамики, т.е. в идеале внешний винт на полочке хранить).

Я думаю Самсунг перевела PRO линейку на память TLC исходя из того, что EVO будет на QLC.

Таким образом мы наблюдаем общее падение...

Наверное это продиктовано рынком и возможно техническими нюансами.

Мы и все потребители подстроимся под новые реалии, ведь другого пути не видно. Ничего. Можно менять или обновлять накопители примерно раз в 4-5 лет.

Хотя мой Crucial m4 128gb работает в качестве системно-игрового уже восьмой год.

Конечно в профиле у меня указан 860EVO 500Gb, но он для увесистых современных игр + то, что должно быть под рукой и немного семейного архива, хотя последний конечно продублирован на классическом HDD, ведь длительное хранение информации лучше осуществлять на "блинах" (при этом желательно меньше динамики, т.е. в идеале внешний винт на полочке хранить).

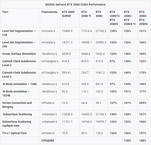

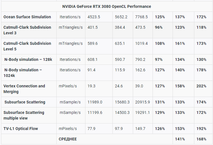

Новая видеокарта NVIDIA GeForce RTX 3080 прошла тесты CUDA и OpenCL в пакете Compubench, благодаря чему удалось сопоставить её с предшественницей GeForce RTX 2080 SUPER.

|

|

А если считать чисто по количеству CUDA ядер, то прирост должен был быть 195%

8704 vs. 2944

И имбицилы на реддите говорят, что я несу бред, когда говорю что производительность на TFLOP у новых карт ниже.

Nvidia увеличили вдвое количество CUDA в каждом SM и немного добавили кэша и всего такого. Получается, они сделали этакий "Bulldozer" - непропорционально увеличили число вычислительных блоков относительно других важных компонентов. Да и бенчмарки тока в 4К, чтобы максимально показывать профит от увеличения пропускной способности памяти.

Надо упомянуть, что исполнительные блоки занимают очень мало место на чипе, в сравнение с тем-же кэшем. Поэтому "подсыпать ещё CUDA ядер" - это дешёвое решение с точки зрения использования площади чипа.

Значимая часть CUDA будут простаивать, т.к. они не будут успевать получать достаточно задач и данных для обработки. Поэтому 36 терафлопсов у 3090 совсем не +160% производительности, а примерно +100, что и было показано на презентации, причём в лучшем свете.

Таким образом, у RTX 3000 намного ниже "IPC".

Ну и получается, что если IPC падает на 30%, то 3090 будет сравнима с Turing @25 TFLOPS, и Navi 21 с 80 CUs будет не сильно отставать - наверняка сможет конкурировать с 3080.

Но "IPC" скорее упал на 15-25%, в зависимости от сценария. Я осмелюсь вангануть, что чем ниже разрешение рендера, тем выше падание "IPC".

С другой стороны, профилинг драйверов позволит постепенно раскрывать потанцевалы Ампера.

В любом случае, суть в том, что AMD не придётся делать карту, которая может в 30 терафлопс, чтобы тягаться с 3080, ибо попугаи теперь очень разные. Turing и RDNA 1 были похожие по "IPC". Ampere убавил IPC, но брутфорсит количеством ядер, RDNA 2 скорее добавит +10% IPC и 100% ядер.

А чем флопсы у видюхи померить?

А чем флопсы у видюхи померить?

Теоретические флопсы мереются по формуле: "ядра" x 2 x частота

Например 1080 TI с шикарным охладом (бустит без просадок): 3584 CUDA x 2 x 1860 = 14.5

У AMD всегда по 64 "ядер" в CU, поэтому: CU x 64 x частота x 2

Для 5700XT получается 40 * 64 * 1900 * 2 = 9.8

Для Navi 21 вангуют 80 * 64 * ??? * 2 = 19.5-22.5 TFLOPS при частотах от 1900 до 2200 соответственно.

Этот метод часто критикуют, однако всякие Хуанги и прочие Лизы Су и кучи блоггеров не противятся "флопсам".

Сравнительно в пределах одной архитектуры этот подход нормальный.

Когда сравнивают разные архитектуры, то нужно брать средний FPS по куче тестов, делать матан FPS/TFLOP и этими соотношениями конвертировать туда-сюда. В целом получается весьма точно.

В случае с анонсом 3000 серии, пока непонятно, в каких игорях бенчили 3000 vs 2000, поэтому точные цифры получить нельзя. Слишком много неизвестных переменных.

Но уже видно, что прирост производительности не пропорционален приросту TFLOPS, значит соотношение PERF/TFLOP однозначно упало, хотя улучшенный DLSS может всё развернуть в сторону Ampere, в игорях где это поддерживается.

Ещё можно смотреть на пропускную способность памяти. Гигабайты в секунду не врут, а вешать дофига быструю память на говночип никто не будет. Но там есть прикол с эффективностью сжатия памяти, так что опять нельзя свавнивать напрямую разные архитектуры.

И есть другие боттлнеки, например слабый геометрический процессор в той-же Vega, или плохой скейлинг по количеству ядер.

А что на сегодня можно сказать про физх от НВ ?

Умер так как и стереоизображение. Я имею в виду аппаратные заметные эффекты.

При выборе видеокарточки можно забить на это ?

Умер так как и стереоизображение. Я имею в виду аппаратные заметные эффекты.

При выборе видеокарточки можно забить на это ?

Mechanical, физикс вроде не помер, а стал опенсорс и теперь тупа в движках "с завода" идет. Тупо объяснгил, но думаю смысл понятен

Цитата

С другой стороны, профилинг драйверов позволит постепенно раскрывать потанцевалы Ампера.

Вот-вот. Мы получили прирост в реальных приложениях и тестах ~70% с дорелизными дровами. Т.е. через полгодика он будет еще выше. Звучит вкусно, я в деле. Учитывая, что я предусмотрительно не покупал 2ххх серию, я прям доволен.

Цитата

А что на сегодня можно сказать про физх от НВ ?

PhysX - физический движок. Используется повсеместно во множестве игорь. На выбор видеокарты влияет никак, программно поддерживается АМД картами. Если ты спрашиваешь о наборе продвинутых эффектов а-ля "Advanced PhysX" - да, они не умеют на АМД картах работать, а на ЦПУ считаются медленно. Обычно это какой-нить физичный туман / дым, коллизящийся огонь / искры. Но реально мало кто сейчас пользует и существенной причиной брать НВидиа карту я их точно не считаю

...Если ты спрашиваешь о наборе продвинутых эффектов а-ля "Advanced PhysX" - да, они не умеют на АМД картах работать, а на ЦПУ считаются медленно. Обычно это какой-нить физичный туман / дым, коллизящийся огонь / искры. Но реально мало кто сейчас пользует и существенной причиной брать НВидиа карту я их точно не считаю

Про это я спрашивал. Спасибо. Да, интересны именно эффекты считаемые на GPU по типу Borderlands 2, Бэтмен, Анабиоз:сон разума и т.д.

Раньше, когда НВ его активно продвигала (в том же Метро 2033), то иногда это служило поводом взять карточку от зеленых, потому что бонусом к ней игрок получал дополнительные приятные эффекты.

Теперь при анонсе игр мы редко стали слышать про подобные плюшки. Ну так лучше и проще при выборе. Нет явной проприетарной эксклюзивности что-ли. Более честная конкуренция получается.

==================================

Подскажите, а в грядущих консолях будет 16 потоков или 8 по одному на каждое ядро CPU ?

По слухам, завтра что-то будет от AMD...

Размеры...

Цитата(videocardz.com)

NVIDIA GeForce RTX 30 family photo

GeForce RTX 30 graphics card sizes:

RTX 3090: 13.8 cm (W) x 31.3 cm (L), 3-slot

RTX 3080; 11.cm (W) x 28.5 cm (L), 2-slot

RTX 3070: 11.2 cm (W) x 24.2 cm (L), 2-slot

GeForce RTX 30 graphics card sizes:

RTX 3090: 13.8 cm (W) x 31.3 cm (L), 3-slot

RTX 3080; 11.cm (W) x 28.5 cm (L), 2-slot

RTX 3070: 11.2 cm (W) x 24.2 cm (L), 2-slot

Размеры...

Ну а чем ещё охлаждать 350-ватт кипятильник?

Nvidia не хотят, чтобы их карты сравнивали с фенами и реактивными турбинами, поэтому идут на такие меры. Есть ещё картинка Sapphire Pulse с кулером "насквозь", так что Navi могут бвть с похожей системой охлада.

И с 12-пин тоже тактично - пусть карта и не будет жрать 500 ватт, но нужен реально качественный БП, который сможет выдавать чистые 350 ватт без просадок. И такой 12-пин коннектор будет у годных БП, которые могут сглаживать пиковую нагрузку.

Вон Asus уже говорят, что КЕЧ 3000 из-за прожорливости вызвала ряд новых инженерных проблем, и на некоторые карты будут ставить индикатор просадки по 12В линии - чтобы было понятно, что если карта глючит/отрубается, то у юзера блок питания не смог быстро выровнять напряжение при внезапном скачке энергопотребления карты. Т.е. вместо 12-пин, Asus будут юзать 2-3 шт 8-пин и индикатор.

Пример просадки напруги из жизни: лампа накаливания тускнеет на пол секунды, когда включается холодильник.

Часть "проблем драйверов Radeon 5700XT" - это на самом деле проблема БП, которые не могут держать ровную напругу при скачках энергопотребления. Некоторым юзерам помогла замена одного раздвоенного 8-пин на 2 отдельных 8 пин шнуров, другие меняли БП.

У Nvidia требования к БП ещё жёстче, так что придумали "фильтр" для говно БП в лице 12-пин. А уж партнёры типа Asus могут ставить 8-пин и разбираться с гаранией, городить диоды-индикаторы и прочее.

Лично я буду ждать уровень 3060 или аналог от радеонов и тогда думаю можно брать. Прогнозирую 25-27к за это у нас в РФ.

Для full hd карты этого уровня будут отличными с запасом на несколько поколений.

Для full hd карты этого уровня будут отличными с запасом на несколько поколений.

Новые процессоры Ryzen будут представлены 8 октября, а видеокарты Radeon — 28 октября

Глава AMD Лиза Су (Lisa Su) только что короткое рекламное видео, которое содержит дату анонса новых процессоров Ryzen на архитектуре Zen 3. А на официальной страничке Radeon в Twitter аналогичное видео, посвящённое новым видеокартам Radeon RX 6000. Итак, процессоры появятся первыми — их представят 8 октября. Видеокарты анонсируют спустя три недели — 28 октября.

Глава AMD Лиза Су (Lisa Su) только что короткое рекламное видео, которое содержит дату анонса новых процессоров Ryzen на архитектуре Zen 3. А на официальной страничке Radeon в Twitter аналогичное видео, посвящённое новым видеокартам Radeon RX 6000. Итак, процессоры появятся первыми — их представят 8 октября. Видеокарты анонсируют спустя три недели — 28 октября.

Ооочень странное подключение питальника, ну прям жесть чет

На 3070 к слову такой дичи нет

На 3070 к слову такой дичи нет

Думаю апгрейдить монитор с

34" Samsung Curved C34F791WQI

на

34" LG 34GN850-B

Что думаете? Стоит менять? Или 3-летний Самсунг еще продержиться против нового LG?

34" Samsung Curved C34F791WQI

на

34" LG 34GN850-B

Что думаете? Стоит менять? Или 3-летний Самсунг еще продержиться против нового LG?

Цитата(Boogeyman @ 11.09.2020, 03:26)

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Уже несколько лет работаю и играю на 34. На меньшую диагональ теперь смотреть больно =)

Планирую перейти на 38, когда цены будут адекватные. =)

Цитата(Boogeyman @ 11.09.2020, 03:26)

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Уже несколько лет работаю и играю на 34. На меньшую диагональ теперь смотреть больно =)

Планирую перейти на 38, когда цены будут адекватные. =)

Я склонен к тому , что для такого соотношения сторон и тем более для 32:9 кривизна будет только в плюс, если сильно не углубляться в проф. черчение или типа того.

Вроде наибольшая кривизна на данный момент наблюдается у моников с радиусом кривизны 1,5 метра. Не сильно ли загнули ? То надо в живую смотреть...

у меня 32" 16:9 1000R монитор. Первый час было непривычно. Сейчас всё нравится

Цитата(Boogeyman @ 11.09.2020, 03:26)

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Думаю апгрейдить монитор с

Как вообще на 21:9? Имею сейчас 27' 1080 монитор, думаю за 1440 32' 21:9, но боюсь что глаз не примет.

Уже несколько лет работаю и играю на 34. На меньшую диагональ теперь смотреть больно =)

Планирую перейти на 38, когда цены будут адекватные. =)

Я склонен к тому , что для такого соотношения сторон и тем более для 32:9 кривизна будет только в плюс, если сильно не углубляться в проф. черчение или типа того.

Вроде наибольшая кривизна на данный момент наблюдается у моников с радиусом кривизны 1,5 метра. Не сильно ли загнули ? То надо в живую смотреть...

У меня были мониторы с кривизной 1500 и 1900. К обоим вариантам привыкаешь очень быстро.

Кривизна мониторов - это абсолютно индивидуальный вопрос к предпочтению пользователя.

Мне больше всего понравилась 1900, для работы этот вариант точно удобнее ИМХО.

Хотя у меня сейчас стоит Самсунг с кривизной 1500 и я не жалусь.

Изучая рынок, наткнулся на очень интересный вариант от Самсунг LC49RG90SSIXCI.

Цена за 49 дюймов просто сказка!

Теперь не вижу смысла менять 34 на новый 34 )))

Но для полноценного наслаждения 49 нужна минимум RTX3080, а следовательно и новая система с поддержкой PCIE4. Это капец )))

Вот думаю, нафик оно все надо, если уже есть ПС4 и 55 телик. ))))

С другой стороны, на 3080 и 49 дюймах Киберпанк будет просто бомбезным. ))))

Думаю, даже ПС5 будет тихонько курить в сторонке. ))))

Но тут возникает проблема, что далеко не все игры поддерживают 21:9, не говоря уже о 32:9... (((

Но для полноценного наслаждения 49 нужна минимум RTX3080, а следовательно и новая система с поддержкой PCIE4. Это капец )))

Вот думаю, нафик оно все надо, если уже есть ПС4 и 55 телик. ))))

Вот думаю, нафик оно все надо, если уже есть ПС4 и 55 телик. ))))

Вангую 30 FPS с просадками на четвёртой плойке, к тем более, норм разрешение будет только на PS4 Pro.

Для КЕЧ 3080 не нужен PCI-E 4. Пока раскроют потанцевалы RTX IO (то есть DirectX Storage или как там называется API майков), уже почти появится PCI-E 5.

С другой стороны, Sony могут взять и выпустить PS5 игру на PC, и потребуют быстрый SSD. Но я думаю, при недостаточно быстром SSD, там просто будут дольше прогружаться текстуры в макс качестве. Главное, чтобы запрос/ответ на базовый ассет прошёл достаточно быстро (тут версия PCI-E роли почти не играет) - тогда не будет статтеров.

Что касается больших экранов, я подключал ноут к большому 720р телеку и с дивана оно выглядело весьма вкусно (я вроде играл с суперсэмплингом 1080p->720p, но это не точно). Т.е. подключай комп к 55 телеку, не меняй видяху, шпиль киберпанк и не парься.

Для просмотра полной версии этой страницы, пожалуйста, пройдите по ссылке.