Полная версия этой страницы: Aпгрейд компьютера

Страницы: 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40, 41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80, 81, 82, 83, 84, 85, 86, 87, 88

KoNoRIMCI, поздравляю  Референс от нвидиа конечно классно выглядит

Референс от нвидиа конечно классно выглядит  А я очень надеюсь что для пятерки и моей 660 хватит

А я очень надеюсь что для пятерки и моей 660 хватит

В целом доволен. Конечно в 2015 году обзавестись улучшенным в 2013 году топом 2012 года за такие деньги не совсем то, но после GTX460 это как свежий глоток воздуха. Самое главное он референсный, тихая и эффективная турбина использующаяся в старших линейках видеокарт. Очень редкая модификация видеокарты в моих краях!

Что качается игр, то разочаровала меня не карта, а оптимизация Assassin's Creed Unity. В ней даже на минимальных настройках на моём конфиге наблюдаются лаги и подтормаживания, при этом забито 1.8ГБ видеопамяти. В меню без вертикальной синхронизации нагрузка на систему больше чем во время игры, аналог волосатого бублика. Watch_Dogs ещё не запускал.

Пока разбираюсь с особенностями GPU Boost 2.0, но думаю я его окончательно отключу* модификацией BIOS'а. Оставлю или базовую частоту 1046МГц при напряжении 1.112В, или максимальную бустовую в качестве базовой 1140МГц при 1.2В. Стоят ли эти постоянные 94МГц прироста производительности покажут тесты. Но скачки 1046, 1058, 1071, 1084, 1097, 1110, 1124 мне не нравятся. Да, при текущей температуре окружающей среды ~50% времени я вижу потолок в виде 1124МГц, но стоит немного потеплеть или прогреться помещению и картина изменится. Самое интересное при активном GPU Boost у видеокарты в приоритете тишина.

* Kepler BIOS Tweaker позволяет полностью выключить технологию разгона GPU Boost 2.0, но тогда утилиты не корректно показывают Boost Limit. Обычно это поле должно быть серым не доступным, а я вижу " MHz" или "0 MHz". Тогда изучив опыт зарубежных коллег поступил как и они, просто для базовой и бустовой частоты указал одно значение.

Подобные скриншоты менее информативные, как и куча цифр в Excel. Для этих целей лучше использовать функционал MSI Afterburner, с его помощью можно открыть в формате hml, он же умеет и создавать их. Автору респект! Он не только реализовал мои пожелания, но и добавил много полезного нового!

"Мой лысый бублик"

"Мой лысый бублик"

Для тестирования использовал различные тяжёлые технологические демки от nVidia и Epic Games. Тяжёлые сцены на Unreal Engine 4 очень хорошо прогревают видеокарты!

Думаю понятно почему я выбрал именно 1124 МГц, и это даже не разгон. Изменений в BIOS'е минимум, а частоты максимальные на всём промежутке тестов, при этом турбина крутится на 50% при 2050-2100 об/мин. Тишина и другие комплектующие внутри системного блока не жарятся. Можно ещё предел температуры сдвинуть с 79* до 95* градусов, но я не стал. Искать стабильную частоту для разрешенного напряжения, разбираться с разблокировкой напряжения буду потом. Знаю только то, что его можно повысить на 12 мВ через MSI Afterburner, по другому только через изучение множества настроек Kepler BIOS Tweaker. Но моя цель оптимальная производительность/шум/температура.

В другой раз моё впечатление от NVENC, его использовании при конвертировании и захвате видео. Спасибо за внимание!

Что качается игр, то разочаровала меня не карта, а оптимизация Assassin's Creed Unity. В ней даже на минимальных настройках на моём конфиге наблюдаются лаги и подтормаживания, при этом забито 1.8ГБ видеопамяти. В меню без вертикальной синхронизации нагрузка на систему больше чем во время игры, аналог волосатого бублика. Watch_Dogs ещё не запускал.

Пока разбираюсь с особенностями GPU Boost 2.0, но думаю я его окончательно отключу* модификацией BIOS'а. Оставлю или базовую частоту 1046МГц при напряжении 1.112В, или максимальную бустовую в качестве базовой 1140МГц при 1.2В. Стоят ли эти постоянные 94МГц прироста производительности покажут тесты. Но скачки 1046, 1058, 1071, 1084, 1097, 1110, 1124 мне не нравятся. Да, при текущей температуре окружающей среды ~50% времени я вижу потолок в виде 1124МГц, но стоит немного потеплеть или прогреться помещению и картина изменится. Самое интересное при активном GPU Boost у видеокарты в приоритете тишина.

* Kepler BIOS Tweaker позволяет полностью выключить технологию разгона GPU Boost 2.0, но тогда утилиты не корректно показывают Boost Limit. Обычно это поле должно быть серым не доступным, а я вижу " MHz" или "0 MHz". Тогда изучив опыт зарубежных коллег поступил как и они, просто для базовой и бустовой частоты указал одно значение.

Подобные скриншоты менее информативные, как и куча цифр в Excel. Для этих целей лучше использовать функционал MSI Afterburner, с его помощью можно открыть в формате hml, он же умеет и создавать их. Автору респект! Он не только реализовал мои пожелания, но и добавил много полезного нового!

"Мой лысый бублик"

"Мой лысый бублик" Для тестирования использовал различные тяжёлые технологические демки от nVidia и Epic Games. Тяжёлые сцены на Unreal Engine 4 очень хорошо прогревают видеокарты!

Думаю понятно почему я выбрал именно 1124 МГц, и это даже не разгон. Изменений в BIOS'е минимум, а частоты максимальные на всём промежутке тестов, при этом турбина крутится на 50% при 2050-2100 об/мин. Тишина и другие комплектующие внутри системного блока не жарятся. Можно ещё предел температуры сдвинуть с 79* до 95* градусов, но я не стал. Искать стабильную частоту для разрешенного напряжения, разбираться с разблокировкой напряжения буду потом. Знаю только то, что его можно повысить на 12 мВ через MSI Afterburner, по другому только через изучение множества настроек Kepler BIOS Tweaker. Но моя цель оптимальная производительность/шум/температура.

В другой раз моё впечатление от NVENC, его использовании при конвертировании и захвате видео. Спасибо за внимание!

До замены видеокарты:

После установки новой:

От обычных HDD в формфакторе 3.5 дюйма полностью отказался, в системе два SSD. Для второстепенного контента использую ноутбучный (2.5, 500, 7200) в кармане Zalman ZM-VE300. В планах добавить WiFi PCI-E плату и раздобыть нормальные не "Г" образные шлейфы с защёлками.

После установки новой:

От обычных HDD в формфакторе 3.5 дюйма полностью отказался, в системе два SSD. Для второстепенного контента использую ноутбучный (2.5, 500, 7200) в кармане Zalman ZM-VE300. В планах добавить WiFi PCI-E плату и раздобыть нормальные не "Г" образные шлейфы с защёлками.

jamakasi,

Достал из ящика "", куплена больше 2х лет назад.

Осталось разобраться со шлейфами.

Достал из ящика "", куплена больше 2х лет назад.

Осталось разобраться со шлейфами.

HikeR,

Греет карту не хило, т.к. вторая версия GPU Boost управляет напряжением. Будет лето с 30 градусной жарой в помещении и рёв СО обеспечен. Если понадобится разогнать видеокарту сделаю это руками. В противном случае выключу буст и зашью базовые частоты - 1045 МГц при 1.112В.

Карта в 3D приложениях будет всегда работать на заданных мною частотах. В данном случае это не 1046МГц, а верхняя планка буста 1124МГц. Всё как во времена Fermi, когда я сидел на GTX460.

Греет карту не хило, т.к. вторая версия GPU Boost управляет напряжением. Будет лето с 30 градусной жарой в помещении и рёв СО обеспечен. Если понадобится разогнать видеокарту сделаю это руками. В противном случае выключу буст и зашью базовые частоты - 1045 МГц при 1.112В.

Карта в 3D приложениях будет всегда работать на заданных мною частотах. В данном случае это не 1046МГц, а верхняя планка буста 1124МГц. Всё как во времена Fermi, когда я сидел на GTX460.

вторая версия GPU Boost управляет ...

... частотой в зависимости от температуры, а не от общего энергопотребления, как в 1.0. если температура не превышает XX градусов, то будет расти частота, напряжение выше дефолтного не поднимется, оно умеет только понижаться.

если уж и бороться за температуру, то правильнее и проще уменьшить именно "желаемую" температуру, а не отключать целиком одну из киллер–фич.

Карта в 3D приложениях будет всегда работать на заданных мною частотах

повторюсь, зачем??? DWM в винде - 3Д, браузер - 3Д, видеоплеер - 3Д, приложение на последнем Qt - тоже 3Д. будешь ручками составлять список исключений в настройках драйвера?

верхняя планка буста 1124МГц

это не верхняя, это "средняя" планка. ничего не трогая у меня на 980-й частота уверенно держится в районе 1500 МГц при дефолтном бусте в 1216. а при прогоне Heaven Benchmark снижается даже ниже дефолтных 1126, ибо жарко становится.

а без буста при слишком большой нагрузке карточка будет просто перегреваться и завывать.

HikeR,

Я её полностью не отключал, она продолжает выполнять свои дополнительные функции! Уже проверил, при достижении температурного лимита начнёт скидывать напряжение/частоту по таблице "Boost".

Для этого экземпляра это верхняя планка. Даже при 100% оборотах турбины и 65* градусах только 1124МГц, упирается в напряжение, в некоторых обзорах видел 1136МГц. Не стоит сравнивать революционный экономичный и высокопроизводительный Maxwell с Kepler.

Мне нужен был аппаратный способ уменьшения температуры. Утилиты с регулировкой "Power Limit" и "Temp Limit" для меня не вариант, иногда из-за них могут вылетать игры.

Можно выбирать между температурой и энергопотреблением, но да, напряжение выше дефолтного не поднимется. Всё началось с того, что я хотел исключить все напряжения/частоты выше 1046МГЦ/1.112В, аппаратно заблокировать буст на базовой частоте. Потом решил верхнюю планку выставить в качестве базовой. За час игры в BF4 на ультра настройках без вертикальной синхронизации карта прогревается до 80* градусов при ~2300 об/мин. СО работает тихо. Всё получилось.

В общем время покажет, может передумаю и верну всё как было, а управлять буду софтово через MSI Afterburner.

Цитата

если уж и бороться за температуру, то правильнее и проще уменьшить именно "желаемую" температуру, а не отключать целиком одну из киллер–фич. А без буста при слишком большой нагрузке карточка будет просто перегреваться и завывать.

Я её полностью не отключал, она продолжает выполнять свои дополнительные функции! Уже проверил, при достижении температурного лимита начнёт скидывать напряжение/частоту по таблице "Boost".

Цитата

это не верхняя, это "средняя" планка.

Для этого экземпляра это верхняя планка. Даже при 100% оборотах турбины и 65* градусах только 1124МГц, упирается в напряжение, в некоторых обзорах видел 1136МГц. Не стоит сравнивать революционный экономичный и высокопроизводительный Maxwell с Kepler.

Мне нужен был аппаратный способ уменьшения температуры. Утилиты с регулировкой "Power Limit" и "Temp Limit" для меня не вариант, иногда из-за них могут вылетать игры.

Цитата

вторая версия GPU Boost управляет частотой в зависимости от температуры, а не от общего энергопотребления, как в 1.0. если температура не превышает XX градусов, то будет расти частота, напряжение выше дефолтного не поднимется, оно умеет только понижаться.

Можно выбирать между температурой и энергопотреблением, но да, напряжение выше дефолтного не поднимется. Всё началось с того, что я хотел исключить все напряжения/частоты выше 1046МГЦ/1.112В, аппаратно заблокировать буст на базовой частоте. Потом решил верхнюю планку выставить в качестве базовой. За час игры в BF4 на ультра настройках без вертикальной синхронизации карта прогревается до 80* градусов при ~2300 об/мин. СО работает тихо. Всё получилось.

В общем время покажет, может передумаю и верну всё как было, а управлять буду софтово через MSI Afterburner.

из-за них могут вылетать игры

значит слишком много "нарегулировал", у 680-й все-таки имеются свои пределы возможностей.

однако буст 2.0 действительно аппаратное решение, зашей 60° в биос и наступит тишина и спокойствие. и не нужно никаких утилит/афтербарнеров/риватюнеров и тд, разве что кулером порулить иногда.

HikeR,

Тогда был выставлен мониторинг, а BIOS был прошит родной, без каких-либо модификаций.

И получу частоты на уровне 800 МГц, т.к. обороты у вентилятора не будут расти. Не вариант. И кто сказал что меня не устраивает температура в 80* градусов, оптимальный лимит.

Кстати "Kepler BIOS Tweaker" не умеет менять минимальные и максимальные обороты. Проверил уже, графа есть, но крутиться турбина как её хочется. Всё равно придётся подключать софт, включать кривую управления оборотами в зависимости от температуры.

Цитата

значит слишком много "нарегулировал"

Тогда был выставлен мониторинг, а BIOS был прошит родной, без каких-либо модификаций.

Цитата

зашей 60° в биос и наступит тишина и спокойствие

И получу частоты на уровне 800 МГц, т.к. обороты у вентилятора не будут расти. Не вариант. И кто сказал что меня не устраивает температура в 80* градусов, оптимальный лимит.

Кстати "Kepler BIOS Tweaker" не умеет менять минимальные и максимальные обороты. Проверил уже, графа есть, но крутиться турбина как её хочется. Всё равно придётся подключать софт, включать кривую управления оборотами в зависимости от температуры.

я хотел исключить все напряжения/частоты выше 1046МГЦ

не скажу за Keppler, но на многих 980-х в Boost Table максимальная частота указана как 1455.5 МГц, что совершенно не мешает карточке подниматься еще выше в стоке.

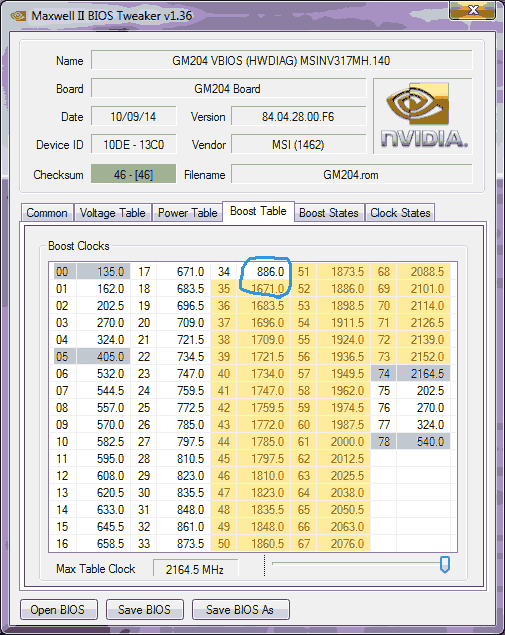

ради интереса выставил вот так:

во какой скачок получился, 886, а потом сразу 1671 МГц. однако видюхн на это дело оказалось пофиг, в 3dmark-е скакало 1200-1300.

как именно видюха работает с этими таблицами одной нвидии известно, но вот гарантированный результат достигается только изменением (Max)Temp Target и Power Table. причем в последнюю лучше не лазить ;)

И кто сказал что меня не устраивает температура в 80* градусов, оптимальный лимит.

тогда непонятно ради чего все это затевалось. карта и так будет держать свои 80°, а при 98° аппаратно выключится.

p.s.

а можно на биос посмотреть? по версии на скриншоте ищется только Galaxy с пониженными частотами.

а можно на биос посмотреть? по версии на скриншоте ищется только Galaxy с пониженными частотами.

HikeR,

"80.04.B4.00.01" - .

Когда в комнате будет 25-30 градусов, видеокарте чтобы держать эти 80* градусов придётся в первую очередь сбрасывать частоты. Я решил принудительно выбрать "щадящее" напряжение при оптимальной базовой частоте, значения которых не позволят температуре добираться до 80* градусов. А GPU Boost'у не придётся "плясать частотами", т.к. не будет предела по температуре/напряжению/энергопотреблению.

Вместо 1124МГц таким же способом решил зашить 1202МГц, такая частота есть в таблице BIOS'а, но под нагрузкой всё те же 1124МГц. Где-то ещё есть связь...

PS. Поставил назад родной BIOS. Хочу ещё понаблюдать за GPU Boost v2.0.

"80.04.B4.00.01" - .

Цитата

тогда непонятно ради чего все это затевалось.

Когда в комнате будет 25-30 градусов, видеокарте чтобы держать эти 80* градусов придётся в первую очередь сбрасывать частоты. Я решил принудительно выбрать "щадящее" напряжение при оптимальной базовой частоте, значения которых не позволят температуре добираться до 80* градусов. А GPU Boost'у не придётся "плясать частотами", т.к. не будет предела по температуре/напряжению/энергопотреблению.

Вместо 1124МГц таким же способом решил зашить 1202МГц, такая частота есть в таблице BIOS'а, но под нагрузкой всё те же 1124МГц. Где-то ещё есть связь...

PS. Поставил назад родной BIOS. Хочу ещё понаблюдать за GPU Boost v2.0.

"80.04.B4.00.01" - вот он.

его и имел ввиду, в нем частоты 1046/1084, что ниже номинальных.

видеокарте чтобы держать эти 80* градусов придётся в первую очередь сбрасывать частоты.

необязательно. на одной и той же частоте карточка может снизить (и снижает) напряжение => потребление, если температура позволяет.

после выхода первого Titan у нвидии понятие "базовая частота" перестала означать то, как оно понималось раньше. теперь ее правильнее называть "желаемая производительность в рамках теплопакета". если игра выдает свои стабильные 60 фпс, то карточка вполне может работать даже ниже номинала в самом эффективном режиме, а вмешательство в работу буста приведет лишь к постоянной работе и лишнему нагреву.

но под нагрузкой всё те же 1124МГц. Где-то ещё есть связь...

потребление. чип и так работает на пределе, а на референсах никогда не ставили стопицотфазные регуляторы.

HikeR,

Картинкой ошиблись, ниже слева надпись. Это и есть рекомендуемые частоты от nVidia для GTX 770:

Энергопотребление в тесте было 70%. Через MSI Afterburner можно и дальше гнать, пока не упрётся в напряжение 1.212В.

На сегодня хватит. Пока оставляю родной BIOS, буду играть и дальше наблюдать за поведением GPU Boost v2.0.

Цитата

его и имел ввиду, в нем частоты 1046/1084, что ниже номинальных.

Картинкой ошиблись, ниже слева надпись. Это и есть рекомендуемые частоты от nVidia для GTX 770:

Цитата

потребление. чип и так работает на пределе

Энергопотребление в тесте было 70%. Через MSI Afterburner можно и дальше гнать, пока не упрётся в напряжение 1.212В.

На сегодня хватит. Пока оставляю родной BIOS, буду играть и дальше наблюдать за поведением GPU Boost v2.0.

Это и есть рекомендуемые частоты от nVidia для GTX 770

смутил скрин в #3552 рядом со словом "референс".

Энергопотребление в тесте было 70%

(доставая бубен) на фотке увидел, что карта подключена одним кабелем. если в комплекте БП есть второй, то может что-то изменится с ним?

HikeR,

Исправил скрин.

Блок питания мощный и по одному проводу в состоянии запитать карточку. Включал волосатый бублик и максимальное энергопотребление достигало 99%.

Цитата

смутил скрин в #3552 рядом со словом "референс".

Исправил скрин.

Цитата

на фотке увидел, что карта подключена одним кабелем. если в комплекте БП есть второй, то может что-то изменится с ним?

Блок питания мощный и по одному проводу в состоянии запитать карточку. Включал волосатый бублик и максимальное энергопотребление достигало 99%.

HikeR,

Кстати, хоть какую GTX 980 взял?

Кстати, хоть какую GTX 980 взял?

Блок питания мощный и по одному проводу в состоянии запитать карточку.

хозяин — барин, только ограничение в 150 Вт на один PCI-E разъем не от балды родилось.

> какую GTX 980 взял?

MSI GAMING 4G.

в ноябре 980-х дешевле 22 тыщ просто не было, а в декабре уже не стало ;)

два независимых тихих вентилятора не работающих до 60°, мелкая утилитка переключающая режимы тихий/дефолт/разгон (сразу одновременно частоты/напряжения/обороты), детальки милитари класс, все дела. правда, первая видюха свистела, пищала и сдохла в первый же день. пока ездила обратно, пока гарантийка чесала мозг, цены подскочили чуть ли не в полтора раза... я уже и не надеялся на замену, думал деньги вернут, но обошлось.

HikeR,

Производитель при 100% энергопотреблении указывает на 230Вт. Шина PCI-Express даёт ~70Вт. 230-70=160Вт. Всё ок.

Цитата

хозяин — барин, только ограничение в 150 Вт на один PCI-E разъем не от балды родилось.

Производитель при 100% энергопотреблении указывает на 230Вт. Шина PCI-Express даёт ~70Вт. 230-70=160Вт. Всё ок.

KoNoRIMCI, Нормуль с питанием =) 12В на 54А = хватит с головой.

Эхх, а я хочу чтобы уже поскорее вышли 390х, которые будут со стэковой памятью, и которые (надеюсь, верю, жду) будут рвать титан Х в разрешениях вплоть до 4к

Эхх, а я хочу чтобы уже поскорее вышли 390х, которые будут со стэковой памятью, и которые (надеюсь, верю, жду) будут рвать титан Х в разрешениях вплоть до 4к

Надеюсь что к осени цены на видеокарты чуть упадут, так что сижу и выбираю себе "обновку". Надеюсь что, в который раз, здесь помогут.

Сейчас имеется , хочу его заменить на что-нибудь мощнее.

Новая карточка будет трудиться в одиночку, денег на неё думаю выделить от 15 до 25 тысяч(как получится), за какими моделями посоветуете следить?

Советовали обратить внимание на GTX 970.

Сейчас имеется , хочу его заменить на что-нибудь мощнее.

Новая карточка будет трудиться в одиночку, денег на неё думаю выделить от 15 до 25 тысяч(как получится), за какими моделями посоветуете следить?

Советовали обратить внимание на GTX 970.

Шина PCI-Express даёт ~70Вт. 230-70=160Вт. Всё ок.

до 75 Вт от мамки едят только карточки без доппитания. у остальных (не особо старых) основной преобразователь напряжения к PCI-E разъему даже не подключен (кроме минуса). на PCI-E разъеме всего 5 тонюсеньких контактов на 12 В, задействуют их для вентиляторов да светодиодов "подключите доппитание", могут еще биосы и мониторинговые схемы подключить. цифра 75 Вт - это как работа "китайского" БП 500 Вт на полную мощность.

так что все не совсем ок.

RusStarik, Неее, 970 - это гимпнутая карта, на западных форумах уже 100500 раз доказывали, как она классно свопит и статтерит когда программа требует больше 3.5 гигов.

Подожди ответа от АМД - на Компьютеке выкотят обновку серии, если верить прогнозам, то 390 и 390х с 8ю гигами стэковой памяти будет просто нагибатором титанов (ну или как минимум 90% производительности и при этом дешевле этак бачей на $300), следовательно отодвиднут линейку карт нынешних по ценнику назад - будет больше выбор.

Подожди ответа от АМД - на Компьютеке выкотят обновку серии, если верить прогнозам, то 390 и 390х с 8ю гигами стэковой памяти будет просто нагибатором титанов (ну или как минимум 90% производительности и при этом дешевле этак бачей на $300), следовательно отодвиднут линейку карт нынешних по ценнику назад - будет больше выбор.

HikeR,

В различных статьях упоминается "нуждаются сразу в двух разъемах питания в дополнение к 75 Вт по PCI Express", следовательно авторы этих статей не согласны с написанным выше.

С той же статьи:

Моя модель блока питания имеет только одну 12В линию с нагрузочной способностью до 54А.

Если бы было китайское барахло в качестве БП, то да согласен, в данном случае нет.

Цитата

до 75 Вт от мамки едят только карточки без доппитания.

В различных статьях упоминается "нуждаются сразу в двух разъемах питания в дополнение к 75 Вт по PCI Express", следовательно авторы этих статей не согласны с написанным выше.

С той же статьи:

Цитата(IXBT)

И, подбирая блок питания для мощной игровой системы, нужно обязательно учитывать, что кроме видеокарты в ПК много других потребителей (топовые CPU также очень любят кушать энергию), поэтому стоит обращать внимание на БП, дающие не менее 25 А по минимум двум каналам 12 В. Видеокарты нижнего среднего уровня могут довольствоваться питанием по PCI Express, но им тоже нужны качественные блоки питания.

Моя модель блока питания имеет только одну 12В линию с нагрузочной способностью до 54А.

Цитата

так что все не совсем ок.

Если бы было китайское барахло в качестве БП, то да согласен, в данном случае нет.

KoNoRIMCI, Одна или две,три, четыре линии - значения особого не имеет, покуда есть достаточное количество ампер на линии и бп качественный.

Интел начали рекомендовать делать множественные линии на всяк пожарный, т.к. если линия с большим количеством ампер екнется, то это черевата капутом всей системы, а когда распределено, то якобы шансы снижаются, на деле, все двояко и производители зачастую делают и такие, и такие блоки. Пример: прекрасный ЕВГА 1600В2, который имеет одну 12в линию, но зверски мощную, или же мой Лепа Г1600, который имеет несколькой линий, лимитированный по 30А на линию.

Твоей одной линии в 54А хватит с головой для одной карты + товоей системы + разгон.

Интел начали рекомендовать делать множественные линии на всяк пожарный, т.к. если линия с большим количеством ампер екнется, то это черевата капутом всей системы, а когда распределено, то якобы шансы снижаются, на деле, все двояко и производители зачастую делают и такие, и такие блоки. Пример: прекрасный ЕВГА 1600В2, который имеет одну 12в линию, но зверски мощную, или же мой Лепа Г1600, который имеет несколькой линий, лимитированный по 30А на линию.

Твоей одной линии в 54А хватит с головой для одной карты + товоей системы + разгон.

Naruto,

Это ясно. Просто всё началось с метода подключения. Здесь видно:

Я решил не заморачиваться укладкой ещё одного кабеля и повесил всё на один.

Что касается BIOS'а видеокарты, то оставил родной. Если не включать синхронизацию, то видеокарта постоянно загружена и частота держится в пределах 1084-1124 МГц, ниже базовой 1045 МГц не опускается.

Цитата

Твоей одной линии в 54А хватит с головой для одной карты + товоей системы + разгон.

Это ясно. Просто всё началось с метода подключения. Здесь видно:

Я решил не заморачиваться укладкой ещё одного кабеля и повесил всё на один.

Что касается BIOS'а видеокарты, то оставил родной. Если не включать синхронизацию, то видеокарта постоянно загружена и частота держится в пределах 1084-1124 МГц, ниже базовой 1045 МГц не опускается.

KoNoRIMCI, Ну, я так понимаю, что у тебя от БП есть "родной" (поставлялся с БП) кабель с раздвоением на 6-пиновую головку и 6+2 пиновую, так?

Naruto,

Да.

Да.

KoNoRIMCI, Тогда 100% нормально.

следовательно авторы этих статей не согласны с написанным выше.

авторы этих статей а) копипастят сис. требования производителя, б) не имеют обычного вольтметра, не говоря уже про замеры потребления от слота через PCI-E переходник ()

я на 99% уверен, что радеоны 7970/280X/290X от слота едят меньше 4 Вт (есть знакомый майнер сдвинутый на замерах всего), 1% остается на нереференсы (если они существуют). а вот для сабжевой видюхи гадать не буду, уже несколько лет не встречал нормальных тестирований с замером потребления отдельно по всем слотам/разъемам, максимум "от розетки".

> Моя модель блока питания имеет только одну 12В линию с нагрузочной способностью до 54А.

это потому, что производитель забивает на стандарт и экономит на мониторинге нескольких "виртуальных" линий. такой БП при авариях сожжет все нафиг пока кабеля не расплавятся, но сам, скорее всего, останется жив. кстати, из-за той же экономии присутствуют аж 4 модульных PCI-E разъема с достаточно тонкими проводами 18 AWG (а выглядят даже на 20), которые и предполагают парное подключение.

сейчас могу ошибиться, но отечественные ПЭУ для подобных кабелей регламентируют максимальный ток в ~2 А, то есть доп. разъему PCI-E "положено" не более ~80 Вт.

> решил не заморачиваться укладкой ещё одного кабеля и повесил всё на один.

принцип "и так сойдет" работает только до некоторого времени.

Твоей одной линии в 54А хватит с головой для одной карты + товоей системы + разгон.

речь не о том, что не хватит. на одиночном тонком кабеле 12 В при больших токах легко могут просесть ниже 5% допуска, что немедленно будет принято во внимание преобразователем видеокарты.

Тогда 100% нормально.

это 100 не нормально.

Неее, 970 - это гимпнутая карта, на западных форумах уже 100500 раз доказывали, как она классно свопит и статтерит когда программа требует больше 3.5 гигов.

скорость самого современного PCIe 3.0 16x не может превышать 16 Гб/сек, в то время как скорость "медленного" полгигабайта на 970-й в 3-5 раза выше. при этом Gen 3.0 поддерживают только последние процы и чипсеты, а у самых распространенных PCIe 2.0 16x цифра в два раза ниже.

на этих форумах кто-нибудь смог объяснить, как они обошли "бутылочное горло" интерфейса? а то сильно похоже на подключение SSD к старому SATA 1.0.

а вот к чему это приводит:

Учитывая, что этот ресурс один из первых, кто начал вообще следить за временем вывода каждого кадра, и собственно уличил АМД в свое время в фреймскиппинге, то я ему доверяю.

neogaf tests

совершенно ни о чем, любая карточка при повышении граф. настроек начинает тупить и лагать. при чем тут конкретно 970-я?

а вот к чему это приводит:pcper

еще круче. в батле у 980-й намерили дикие провалы в производительности, а 970-я работает стабильно медленнее, но ровнее.

p.s.

по второй ссылке перешел на тесты одиночных карточек. собсно, еще раз подтвердилось то, что никаких провалов в производительности у 970-й нет при любом потреблении видеопамяти. только простой вывод — при полном задействовании памяти ни 970-я, ни 980-я не обеспечивают играбельный фпс.

HikeR,

Это уже мания, если молния попадёт в дом ... то никакой БП и способ подключения проводов не спасёт. Да и внутренние системы защиты никто не отменял: защита от превышения напряжения, защита от заниженного напряжения, защита от превышения силы тока, защита от превышения максимально допустимой мощности, защита от короткого замыкания на всех выходах, защита от перегрева.

Принцип "и так сойдёт" не был использован, всё подключено через родные провода/штекера блока питания. В будущем все претензии к Seasonic.

Если судить по энергопотреблению видеокарты в играх, то за неделю оно не превышало 80-85% от заявленных 230 Вт, т.е. ~184-200 Вт. Я бублик сутками не гоняю, переживать незачем. В комплекте X-650 все провода с сечением 18 AWG, в X-850 под CPU/PCI-E 16 AWG, под всё остальное 18 AWG. Думая производитель с основной сферой деятельности - производство различных блоков питания, знает что делает, и чем нужно комплектовать свою продукцию.

Цитата

такой БП при авариях сожжет все нафиг пока кабеля не расплавятся, но сам, скорее всего, останется жив.

Это уже мания, если молния попадёт в дом ... то никакой БП и способ подключения проводов не спасёт. Да и внутренние системы защиты никто не отменял: защита от превышения напряжения, защита от заниженного напряжения, защита от превышения силы тока, защита от превышения максимально допустимой мощности, защита от короткого замыкания на всех выходах, защита от перегрева.

Цитата

принцип "и так сойдет" работает только до некоторого времени.

Принцип "и так сойдёт" не был использован, всё подключено через родные провода/штекера блока питания. В будущем все претензии к Seasonic.

Если судить по энергопотреблению видеокарты в играх, то за неделю оно не превышало 80-85% от заявленных 230 Вт, т.е. ~184-200 Вт. Я бублик сутками не гоняю, переживать незачем. В комплекте X-650 все провода с сечением 18 AWG, в X-850 под CPU/PCI-E 16 AWG, под всё остальное 18 AWG. Думая производитель с основной сферой деятельности - производство различных блоков питания, знает что делает, и чем нужно комплектовать свою продукцию.

Да и внутренние системы защиты никто не отменял

мамку/проц/видюху никак не спасет способность БП бесперебойно отдать все свои 54 ампера без падения напряжения ;)

> производитель ... знает что делает, и чем нужно комплектовать свою продукцию.

угу, знает, комплектует. только вместо бархатных мешочков мог бы и провода посурьезнее положить, тогда 4 разъема не потребовалось бы.

> всё подключено через родные провода/штекера блока питания.

всё, но не через все.

HikeR,

Это уже дотошность, лишь бы к чему-нибудь придраться, а не реальные факты.

PS. Что-то сгорит дам знать, признаю свою вину и скажу что HikeR был полностью прав. На этом обсуждение прекращаю.

Это уже дотошность, лишь бы к чему-нибудь придраться, а не реальные факты.

PS. Что-то сгорит дам знать, признаю свою вину и скажу что HikeR был полностью прав. На этом обсуждение прекращаю.

дотошность — это если бы я посоветовал оторвать все разъемы и припаяться напрямую к БП, причем желательно прямо на выходные конденсаторы, чтобы не терять 0.2 В на каждом кабеле.

ты же для красоты кабель-менеджмента не выкидываешь 8-pin доп. питания для мамки, хотя его тоже можно заменить изящным двухпроводным переходничком от основного ATX-кабеля. мамка с процом жрет в 2 раза меньше, чем твоя видеокарта, при этом проводов к ней ты подвел в 2 раза больше (на видео идет 3 провода, на мать — 4 + 2).

по мне это выглядит по меньшей мере странно.

ты же для красоты кабель-менеджмента не выкидываешь 8-pin доп. питания для мамки, хотя его тоже можно заменить изящным двухпроводным переходничком от основного ATX-кабеля. мамка с процом жрет в 2 раза меньше, чем твоя видеокарта, при этом проводов к ней ты подвел в 2 раза больше (на видео идет 3 провода, на мать — 4 + 2).

по мне это выглядит по меньшей мере странно.

Решил апгрейднуть свою видяшку Asus GeForce GTX560 1024Mb и стою перед выбором GeForce 960 GTX или R9 Radeon 280. (в обоих вариантах нравится продукция MSI)

Из радеонов за всю жизнь была аж сапфировская Radeon 9000 256Mb, которая дико бесила из-за драйверов, поэтому к радикам как-то не очень тепло отношусь. В жирафе 960 не очень нравится 128 шина, а про Ti версию, где она должна быть шире, пока тишина. Юзаю FullHD моник. Немного смущает мой БП на 500 Вт в связке с Radeon 280, но вроде как ничего кроме винчестера к нему не подключено, даже сидюк, так что может и потянет.

Или ждать 300 серию радеонов с дальнейшим смещением цен?

Что посоветуете?

Из радеонов за всю жизнь была аж сапфировская Radeon 9000 256Mb, которая дико бесила из-за драйверов, поэтому к радикам как-то не очень тепло отношусь. В жирафе 960 не очень нравится 128 шина, а про Ti версию, где она должна быть шире, пока тишина. Юзаю FullHD моник. Немного смущает мой БП на 500 Вт в связке с Radeon 280, но вроде как ничего кроме винчестера к нему не подключено, даже сидюк, так что может и потянет.

Или ждать 300 серию радеонов с дальнейшим смещением цен?

Что посоветуете?

АМДхи новые выйдут в Июне где-то. Сегодя закрытая презентация партнерам у АМД проходит вроде, так что через 2 месяца уже должны будут выпускать поидее.

А так 960 лучше будет (имхо). Хотя, если 280х найдешь дешевую -> бери.

А так 960 лучше будет (имхо). Хотя, если 280х найдешь дешевую -> бери.

Апгрейднулся на MSI ATI Radeon R9 280X Gaming 3G

Покупкой доволен, все отлично работает на блоке питания 450Вт.

Покупкой доволен, все отлично работает на блоке питания 450Вт.

Сегодня окончательно сдох Asus 7870XT/2GB. Не знаю пока, когда буду апгредиться, в теории нужно что-нибудь помощнее, желательно чтобы дрова под XP имелись. Под XP кто-нибудь современные видюхи запускал?

macron,

Из 9-ой серии зелёных только у GTX960 осталась официальная поддержка Windows XP. За красных не в курсе.

С модифицированными вся 9-ая линейка заводится на XP.

Из 9-ой серии зелёных только у GTX960 осталась официальная поддержка Windows XP. За красных не в курсе.

С модифицированными вся 9-ая линейка заводится на XP.

Ищу ноутбук на замену помирающему , с порогом цены в 30.000р.

Требования просты - первое, и самое важное, нужна живучая(в плане надёжности, срока службы, пылестойкости) машинка; во-вторых, достаточно мощная для работ с графическими редакторами(Adobe Photoshop и, порой, 3ds Max) и что б справлялась с современными играми, особенно ММО(цель - BlackDesert на средних/высоких со стабильными 60/30 fps).

Надеюсь, что не ошибся темой и благодарю за внимание.

Требования просты - первое, и самое важное, нужна живучая(в плане надёжности, срока службы, пылестойкости) машинка; во-вторых, достаточно мощная для работ с графическими редакторами(Adobe Photoshop и, порой, 3ds Max) и что б справлялась с современными играми, особенно ММО(цель - BlackDesert на средних/высоких со стабильными 60/30 fps).

Надеюсь, что не ошибся темой и благодарю за внимание.

RusStarik, попробуй:

Тут на днях мне предложили апгрейд. Я отдаю:

Intel Core2Quad 9550

Gigabyte EP45-Extreme

Corsair DDR2 4GB (2x2GB) + Fan

+ 5000р.

Взамен получаю:

CPU Intel Core i5-2550K 3.4 GHz / 4core / 1+6Mb / 95W / 5 GT / s LGA1155

ASUS P8Z77-V LX2 (RTL) LGA1155 < Z77 > 2xPCI-E+Dsub+HDMI+GbLAN SATA RAID ATX 4DDR-III

Kingston ValueRAM < KVR16R11S8 / 4 > DDR-III DIMM 4Gb < PC3-12800 > ECC Registered with Parity CL11 (2 шт.)

Стоит ли оно того?

P.S. Блочок FSP 800W, Видюха 2GB 7870oc. Свой конфиг брал в начале 2008 года, 2 года назад поменял только видюху (была 1GB 4870 от Saphire)

Intel Core2Quad 9550

Gigabyte EP45-Extreme

Corsair DDR2 4GB (2x2GB) + Fan

+ 5000р.

Взамен получаю:

CPU Intel Core i5-2550K 3.4 GHz / 4core / 1+6Mb / 95W / 5 GT / s LGA1155

ASUS P8Z77-V LX2 (RTL) LGA1155 < Z77 > 2xPCI-E+Dsub+HDMI+GbLAN SATA RAID ATX 4DDR-III

Kingston ValueRAM < KVR16R11S8 / 4 > DDR-III DIMM 4Gb < PC3-12800 > ECC Registered with Parity CL11 (2 шт.)

Стоит ли оно того?

P.S. Блочок FSP 800W, Видюха 2GB 7870oc. Свой конфиг брал в начале 2008 года, 2 года назад поменял только видюху (была 1GB 4870 от Saphire)

Rezzoxe, стоит. Бери.

Решил немного обновится и встал вопрос, что именно менять. Сейчас стоит amd phenom II x6 1090T и gigabyte hd 7950 wf3. Хочу либо поменять процессор на i7 4790, либо видеокарту на GTX 980. Кто что подскажет? Что лучше заменить? Потянет ли старый проц новый видик?

Цитата

что именно менять

ничего или всё. От i7 выхлопа не будет, можно обойтись i5.

Для просмотра полной версии этой страницы, пожалуйста, пройдите по ссылке.